ToF vs LiDAR: qual è la differenza?

Ultimamente, c'è stato così tanto clamore intorno a LiDAR sui nuovi dispositivi Apple che è facile dimenticare che la Realtà Aumentata mobile può funzionare in qualsiasi altro modo. Ma può e lo fa, in particolare con gli strumenti ToF che raggiungono nuove vette nei telefoni Samsung.

Che tu sia uno sviluppatore, alla ricerca di un nuovo dispositivo o semplicemente curioso, vale la pena dedicare un po 'di tempo a scompattare questi acronimi e imparare i dettagli del rilevamento della profondità del telefono cellulare.

Cos'è ToF?

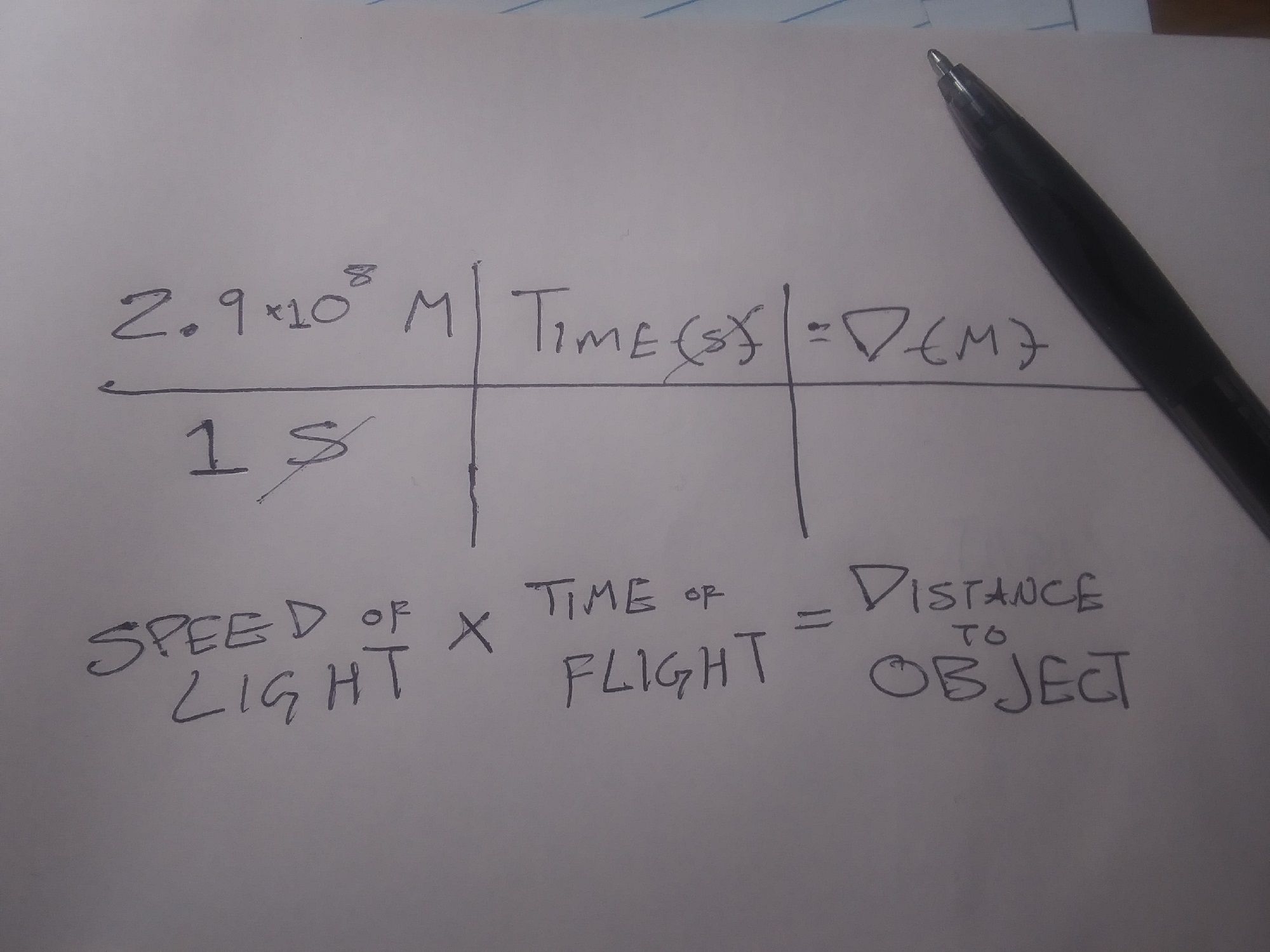

ToF è l'abbreviazione di Time of Flight.

Tecnicamente, ToF si riferisce all'uso della velocità della luce (o anche del suono) per determinare la distanza. Misura il tempo impiegato dalla luce (o dal suono) per lasciare il dispositivo, rimbalzare su un oggetto o un piano e tornare al dispositivo, il tutto diviso per due rivela la distanza dal dispositivo all'oggetto o al piano.

Quindi, la relazione è che tutto il LiDAR è un tipo di tempo di combattimento, ma non tutto il tempo di volo è LiDAR. Per mantenere le cose semplici, quando parliamo di "ToF", intendiamo la misurazione della distanza ottica, escluso LiDAR.

Quindi, se LiDAR e ToF ottico non LiDAR usano entrambi la luce per la determinazione della distanza e la mappatura 3D, in cosa differiscono?

Cos'è LiDAR?

LiDAR è l'acronimo di Light Detection and Ranging . Questa tecnologia utilizza un laser, o una griglia di laser, come sorgente di luce nell'equazione descritta sopra.

Una singola lettura LiDAR può essere utilizzata per misurare cose come la larghezza di una stanza, ma più letture LiDAR possono essere utilizzate per creare "nuvole di punti". Questi possono essere usati per creare modelli tridimensionali di oggetti o mappe topografiche di intere aree.

Sebbene LiDAR possa essere nuovo per i dispositivi mobili, la tecnologia stessa è in circolazione da un po 'di tempo. In ambienti non mobili, LiDAR viene utilizzato per fare di tutto, dalla mappatura di ambienti sottomarini alla scoperta di siti archeologici.

In che modo LiDAR e ToF sono diversi?

La differenza funzionale tra LiDAR e altre forme di ToF è che LiDAR utilizza laser pulsati per costruire una nuvola di punti, che viene quindi utilizzata per costruire una mappa o un'immagine 3D. Le applicazioni ToF creano "mappe di profondità" basate sul rilevamento della luce, solitamente attraverso una telecamera RGB standard.

Il vantaggio di ToF rispetto a LiDAR è che ToF richiede apparecchiature meno specializzate in modo che possa essere utilizzato con dispositivi più piccoli e meno costosi. Il vantaggio di LiDAR deriva dalla facilità con cui un computer può leggere una nuvola di punti rispetto a una mappa di profondità.

L' API Depth che Google ha creato per i dispositivi Android funziona meglio sui dispositivi abilitati ToF e funziona creando mappe di profondità e riconoscendo "punti caratteristici". Questi punti caratteristici, spesso barriere tra diverse intensità di luce, vengono quindi utilizzati per identificare diversi piani nell'ambiente. Ciò crea essenzialmente una nuvola di punti a risoluzione inferiore.

Come ToF e LiDAR funzionano con Mobile AR

Le mappe di profondità e le nuvole di punti sono interessanti e, per alcune persone e applicazioni, sono sufficienti. Tuttavia, per la maggior parte delle applicazioni AR, questi dati devono essere contestualizzati. Sia ToF che LiDAR lo fanno collaborando con altri sensori sul dispositivo mobile. In particolare, queste piattaforme devono comprendere l'orientamento e il movimento del telefono.

Dare un senso alla posizione del dispositivo all'interno di un ambiente mappato si chiama Localizzazione e mappatura simultanee o "SLaM". SLaM viene utilizzato per altre applicazioni come i veicoli autonomi , ma è più necessario che le applicazioni AR basate su dispositivi mobili collochino oggetti digitali nell'ambiente fisico.

Ciò è particolarmente vero per le esperienze che rimangono sul posto quando l'utente non interagisce con esse e per il posizionamento di oggetti digitali che sembrano essere dietro persone fisiche e oggetti.

Un altro fattore importante nel posizionamento di oggetti digitali in entrambe le applicazioni basate su LiDAR e ToF riguarda gli "ancoraggi". Le ancore sono punti digitali nel mondo fisico a cui sono "attaccati" gli oggetti digitali.

Nelle applicazioni su scala mondiale come Pokemon Go, questo viene fatto attraverso un processo separato chiamato "Geotagging". Tuttavia, nelle applicazioni AR basate su dispositivi mobili, l'oggetto digitale è ancorato a punti in una nuvola di punti LiDAR o in uno dei punti caratteristici su una mappa di profondità.

LiDAR è migliore di ToF?

A rigor di termini, LiDAR è più veloce e più preciso del tempo di volo. Tuttavia, questo diventa più significativo con applicazioni tecnologicamente più avanzate.

Ad esempio, ToF e l'API Depth di Google hanno difficoltà a comprendere piani grandi e di bassa consistenza come i muri bianchi. Ciò può rendere difficile per le applicazioni che utilizzano questo metodo posizionare accuratamente gli oggetti digitali su alcune superfici nel mondo fisico. Le applicazioni che utilizzano LiDAR hanno meno probabilità di avere questo problema.

Tuttavia, è improbabile che le applicazioni che coinvolgono ambienti più grandi o più variati dal punto di vista strutturale abbiano questo problema. Inoltre, la maggior parte delle applicazioni AR di consumo basate su dispositivi mobili prevede l'utilizzo di un filtro AR sul viso o sul corpo dell'utente , un'applicazione che è improbabile che incontri problemi a causa delle grandi superfici non strutturate.

Perché Apple e Google utilizzano sensori di profondità diversi?

Nel rilasciare i loro dispositivi compatibili con LiDAR, Apple ha affermato di aver incluso i sensori e altro hardware per "aprire più flussi di lavoro professionali e supportare app di foto e video professionali". Il rilascio ha anche definito il loro iPad Pro compatibile con LiDAR "il miglior dispositivo al mondo per la realtà aumentata" e ha pubblicizzato le app di misurazione di Apple.

Google non ha fornito spiegazioni così esplicite sul motivo per cui la loro API Depth e la nuova linea di dispositivi di supporto non utilizzano LiDAR. Oltre a lavorare attorno a LiDAR, mantenendo i dispositivi Android più leggeri e più convenienti, c'è anche un importante vantaggio in termini di accessibilità.

Poiché Android funziona su dispositivi mobili realizzati da più aziende, l'utilizzo di LiDAR favorirebbe i modelli compatibili con LiDAR a scapito di tutti gli altri. Inoltre, poiché richiede solo una fotocamera standard, l'API Depth è retrocompatibile con più dispositivi.

In effetti, l'API Depth di Google è indipendente dal dispositivo, il che significa che gli sviluppatori che utilizzano la piattaforma di creazione di esperienze AR di Google possono sviluppare esperienze che funzionano anche su dispositivi Apple.

Hai esplorato il rilevamento della profondità?

Questo articolo si è concentrato principalmente su LiDAR e ToF nelle esperienze AR basate su dispositivi mobili. Ciò è in gran parte dovuto al fatto che queste esperienze più complesse richiedono la maggior parte delle spiegazioni. È anche perché queste esperienze sono le più divertenti e le più promettenti.

Tuttavia, approcci di rilevamento della profondità come questi sono alla base di molte esperienze e strumenti più semplici e più pratici che potresti utilizzare ogni giorno senza pensarci troppo. Si spera che leggere su ToF e LiDAR ti dia un ulteriore apprezzamento per queste applicazioni.