La fotocamera del mio iPhone 14 Pro è rovinata ed è tutta colpa di Apple

Ogni anno, Apple pubblicizza l’ iPhone come dotato di un incredibile sistema di fotocamere e, sì, l’hardware è sicuramente impressionante. L’ iPhone 14 Pro ha gli ultimi progressi offerti da Apple in termini di aggiornamenti della fotocamera, tra cui un enorme salto a una fotocamera principale da 48 MP con tecnologia pixel-binning (quattro su-pixel per creare un pixel più grande), un teleobiettivo con ottica 3x zoom, modalità notturna più veloce e altro ancora. Ancora una volta, sul fronte hardware, la fotocamera dell’iPhone 14 Pro sembra impressionante. E questo è!

Ma a cosa serve un ottimo hardware della fotocamera quando il software continua a rovinare le immagini che scatti? Fin dall’allineamento dell’iPhone 13 , sembra che qualsiasi immagine presa da un iPhone, a meno che non sia stata scattata in formato ProRaw, abbia un brutto aspetto rispetto a quelle scattate su iPhone più vecchi e sui migliori telefoni Android concorrenti. Questo perché Apple ha alzato il livello della fotografia computazionale e della post-elaborazione ogni volta che scatti una foto. Sta rovinando le mie immagini e Apple ha bisogno di prendere una pillola fredda e abbassarla di un livello.

Queste funzionalità “intelligenti” non sono così intelligenti come affermano

Per scattare foto, abbiamo bisogno di sensori che aiutino a catturare luce e dettagli per creare quelle immagini. Tuttavia, poiché gli smartphone sono molto più compatti di una DSLR completa, i sensori sono piuttosto limitati in ciò che possono fare. Ecco perché Apple, così come altri produttori di smartphone, può fare affidamento sul software per migliorare la qualità dell’immagine delle immagini acquisite su un telefono.

Apple ha introdotto Smart HDR su iPhone nel 2018 e questa funzionalità software è ora alla sua quarta iterazione con la gamma iPhone 14 . Con Smart HDR 4, il dispositivo scatterà più foto con impostazioni diverse e quindi combinerà gli elementi “migliori” di ciascuna immagine in un’unica foto. C’è molta fotografia computazionale in corso con questo processo, e sebbene l’intenzione sia quella di rendere le immagini belle, in realtà fa il contrario.

Potresti averlo notato quando scatti una foto sul tuo iPhone 14 (o iPhone 13) e tocchi immediatamente la miniatura nell’angolo per visualizzare le immagini che hai appena scattato. L’immagine assomiglierà a ciò che hai catturato per un secondo veloce, ma poi appare eccessivamente nitida, con colori che appaiono più artificiali, forse sbiaditi in alcune aree e eccessivamente saturi in altre. Anche il tono della pelle può sembrare leggermente diverso da quello che vedi nella vita reale. Anche se ho adorato la modalità notturna quando ha debuttato per la prima volta sulla serie iPhone 11 , rispetto alla concorrenza ora, la modalità notturna rende le foto troppo “luminose” a causa dell’eccessiva elaborazione e molte foto notturne non sembrano nemmeno essere state scattate a notte.

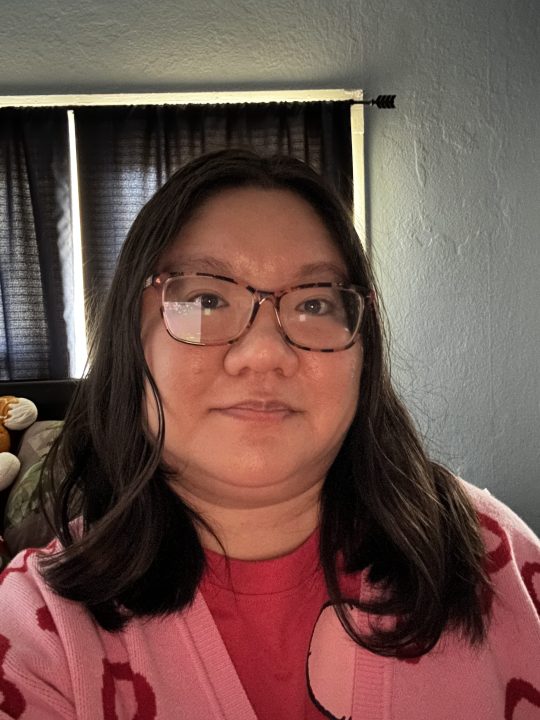

E hai mai provato a fare un selfie in condizioni di scarsa illuminazione? Certo, l’iPhone ha anche la modalità notturna per la fotocamera frontale, ma non l’ho trovato di grande aiuto. I selfie in condizioni di scarsa illuminazione sembrano orrendi, qualunque cosa tu faccia perché iOS aggiunge molti artefatti digitali all’immagine per provare a “salvarla”. Ma invece di salvare la foto, finisce per sembrare un dipinto ad acquerello brutto e disordinato. In effetti, cerco di non scattare selfie sul mio iPhone 14 Pro quando sono in un ambiente buio perché finiscono quasi sempre per sembrare brutti.

Non sono sicuro di quando le foto scattate con un iPhone abbiano iniziato ad apparire in questo modo, ma credo che sia diventato più importante a partire dalla serie iPhone 13. Potrei sbagliarmi, ma non ricordo particolarmente le immagini del mio iPhone 12 Pro che sembrano così esagerate, e soprattutto non le foto del mio iPhone 11 Pro. L’iPhone scattava foto che sembravano realistiche e naturali, ma tutto questo Smart HDR e la post-elaborazione della fotografia computazionale sono sfuggiti di mano, rendendo le immagini peggiori di quanto dovrebbero essere.

Apple, spegniamo questa roba

Alcuni anni fa era possibile non utilizzare affatto lo Smart HDR. Questa era un’impostazione facoltativa e che potevi attivare o disattivare come meglio credi. Questa impostazione era disponibile solo sui modelli iPhone XS, iPhone XR, serie iPhone 11, iPhone SE 2 e iPhone 12. Dall’iPhone 13 e versioni successive, l’opzione per attivare Smart HDR è stata rimossa.

Togliere questa opzione è stata una mossa miope e spero che Apple la riporti a un certo punto. Nonostante il mio iPhone 14 Pro sia il mio dispositivo personale e principale, soprattutto per la fotografia, a volte ho bisogno di modificare un’immagine prima di considerarla adatta alla condivisione con altri. Capisco quello che Apple sta cercando di fare con Smart HDR, ma l’immagine risultante di solito sembra troppo artificiale rispetto a ciò che vedi nella realtà.

Ad esempio, quando scatto foto all’aperto in condizioni di sole, la foto potrebbe avere un cielo blu eccessivamente saturo, facendola sembrare finta. Penso anche che, a volte, l’alterazione del colore renda il tono della mia pelle un po’ fuori posto, qualcosa di cui lo YouTuber Marques Brownlee (MKBHD) parla anche in un video recente .

La concorrenza Android lo fa meglio

Ancora una volta, Apple ha inserito un ottimo hardware per la fotocamera nella gamma di iPhone 14 Pro, ma è contaminato dall’eccessiva elaborazione del software. Dato che ho raccolto alcuni dispositivi Android diversi durante il mio tempo qui a Digital Trends, ho imparato ad apprezzare il modo in cui alcuni telefoni Android concorrenti gestiscono la fotografia sull’iPhone.

Ad esempio, Google Pixel 7 scatta splendide foto con la fotocamera principale senza alcuno sforzo aggiuntivo. Basta puntare e scattare e i risultati sono accurati rispetto a ciò che vedono i tuoi occhi, se non migliori. Google utilizza ancora gran parte della propria elaborazione delle immagini, ma non rende le foto innaturali come fa Apple. L’unico problema, da quello che ho notato, sono i selfie. Non ottiene esattamente il tono della pelle in modo accurato, ma per il resto la fotocamera principale è eccezionale. I colori sono equilibrati, non sbiaditi, e il software non si sforza troppo di farlo “sembrare bello”, perché lo è già. E con strumenti divertenti come Magic Eraser , preferisco usare il mio Google Pixel 7 per modificare gli scatti.

Ho anche testato il vecchio Samsung Galaxy S21 per alcuni di questi confronti fotografici e, anche se non penso che gestisca così bene il tono e il colore della pelle, sembra funzionare bene per i selfie in condizioni di scarsa illuminazione, cosa di cui sono sorpreso. Ha anche gestito abbastanza bene le immagini in modalità notturna, facendole apparire naturali e realistiche invece di spegnersi con i colori spenti come l’iPhone 14 Pro.

Quindi, mentre Apple può dire di avere il “migliore” hardware della fotocamera, iOS e l’eccessiva dipendenza dalla fotografia computazionale stanno rovinando l’aspetto delle immagini. Certo, ad alcune persone potrebbe piacere questa estetica, ma personalmente non sopporto quanto innaturali finiscano per sembrare molte delle mie foto. Apple ha bisogno di attenuare le cose Smart HDR, o almeno ripristinare l’opzione per disattivarlo, se lo desideriamo. Perché, in questo momento, le cose non stanno andando bene.