La serata più voluminosa! La versione di Google di ChatGPT è aperta, Nvidia ha sganciato una scheda grafica per una bomba nucleare… Quando mi sveglio, l’intelligenza artificiale è cambiata di nuovo

Il “momento iPhone” di AI è arrivato

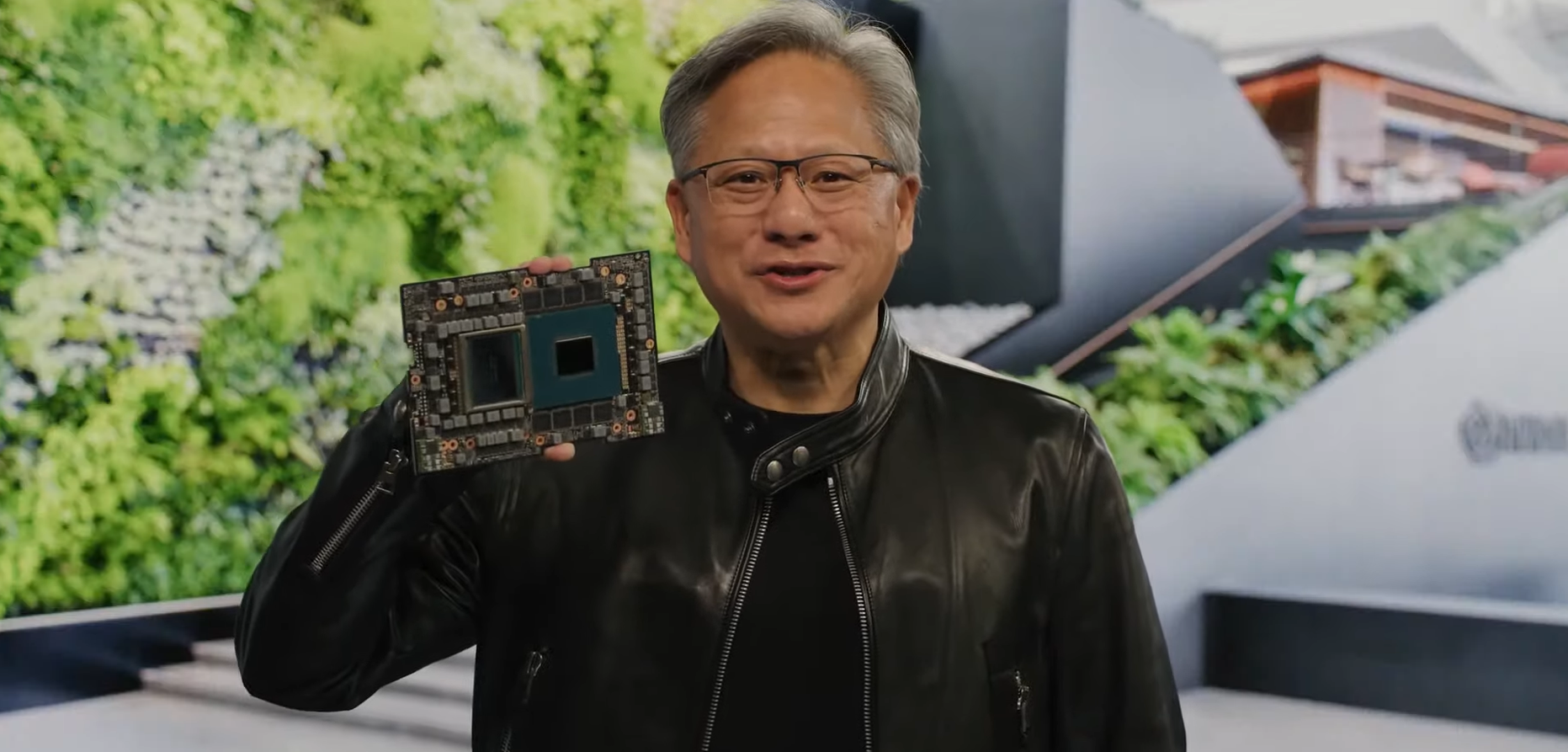

Alla conferenza Nvidia GTC 2023 appena conclusa, il CEO di Nvidia Huang Renxun ha ribadito questo punto di vista tre volte.

Come capire?

La tecnologia dello schermo multi-touch portata dall’iPhone ha creato una nuovissima modalità di interazione dell’interfaccia dello smartphone, che ha dato vita a Internet mobile.

L’emergere di super applicazioni AI come ChatGPT e Stable Diffusion segna la maturità del calcolo accelerato e della tecnologia AI, che sta penetrando in tutti i ceti sociali a una velocità senza precedenti e promuovendo una nuova rivoluzione industriale.

Dopo il continuo sviluppo della tecnologia AI negli ultimi anni, la potente potenza di calcolo e i modelli avanzati forniscono una piattaforma applicativa adatta per l’IA, spingendo vari produttori a reinventare i propri prodotti e modelli di business, nonché la velocità delle iterazioni di aggiornamento.

Ieri sera, Nvidia, Microsoft, Google, Adobe e altri produttori hanno lanciato i rispettivi servizi AI quasi contemporaneamente e la tendenza a rincorrersi sembra trasmettere la stessa ansia:

“In questa era di grandi IA, se non vuoi essere sovvertito dagli altri, devi prima sovvertire gli altri.”

In che modo l’IA cambierà le nostre vite? Dopo aver visto questa “Notte più rumorosa dell’AIGC”, potresti provare una sensazione più profonda.

Nvidia sta portando l’intelligenza artificiale in ogni settore

Nvidia ha portato molte “nuove attività” accattivanti alla conferenza annuale GTC.

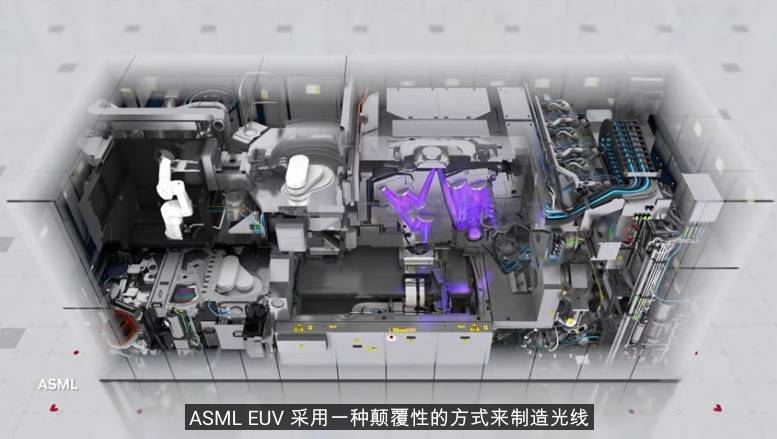

Ad esempio, ha rilasciato una tecnologia di creazione di core assistita dall’intelligenza artificiale chiamata CuLitho, che ha aperto la strada al processo a 2 nm; ha collaborato con case automobilistiche come Lotus, Mercedes-Benz e BMW e ha utilizzato Omniverse per costruire linee di produzione digitali.

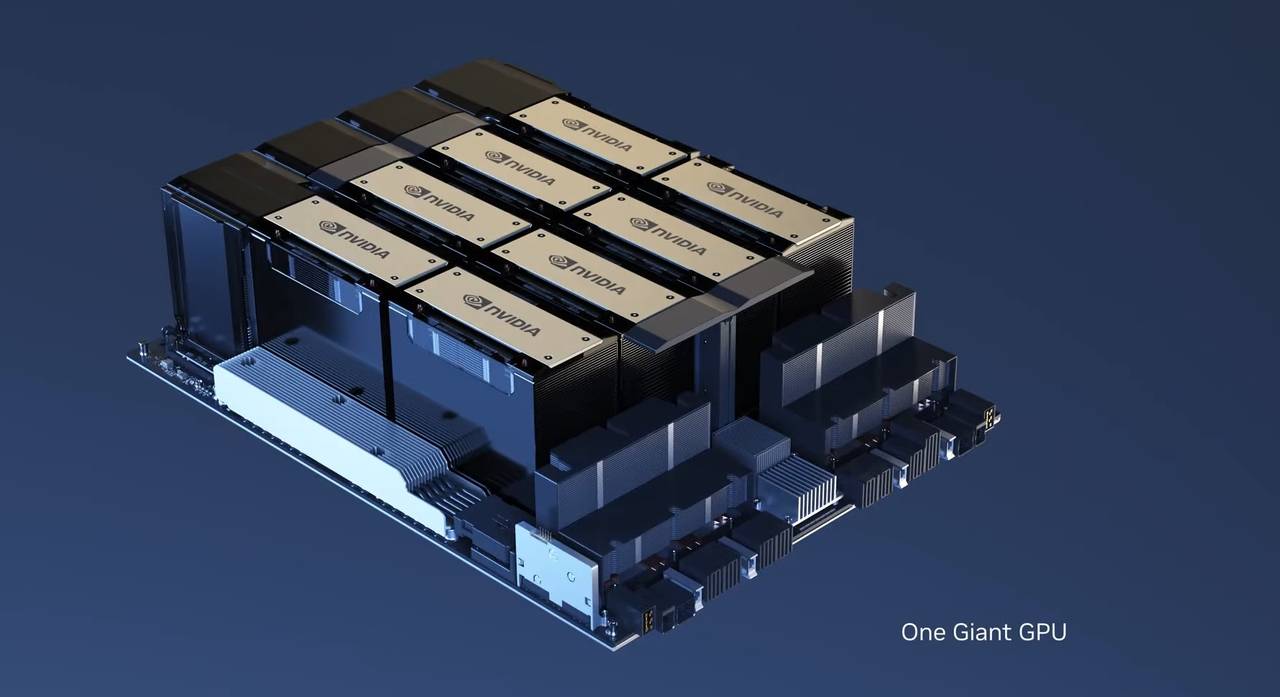

Ma quando si tratta del contenuto più accattivante dell’intera conferenza GTC, deve essere la nuova scheda grafica rilasciata da Nvidia: l’H100 NVL con doppia GPU NVLink.

H100 NVL è una scheda grafica appositamente progettata per ChatGPT, che richiede un’enorme potenza di calcolo.H100 NVL ha una memoria HBM3 da 188 GB esagerata (94 GB per scheda), che è attualmente la scheda di memoria più grande rilasciata da Nvidia.

Un modello di linguaggio di grandi dimensioni come GPT consuma molte risorse di memoria e, in teoria, un modello GPT con centinaia di miliardi di parametri può riempire rapidamente una scheda grafica H100.

Rispetto all’HGX A100 per l’elaborazione GPT-3, un server standard che utilizza quattro coppie di H100 e NVLink a doppia GPU è 10 volte più veloce, la “bomba nucleare” H100 NVL è ideale per l’implementazione su larga scala di modelli linguistici come ChatGPT.

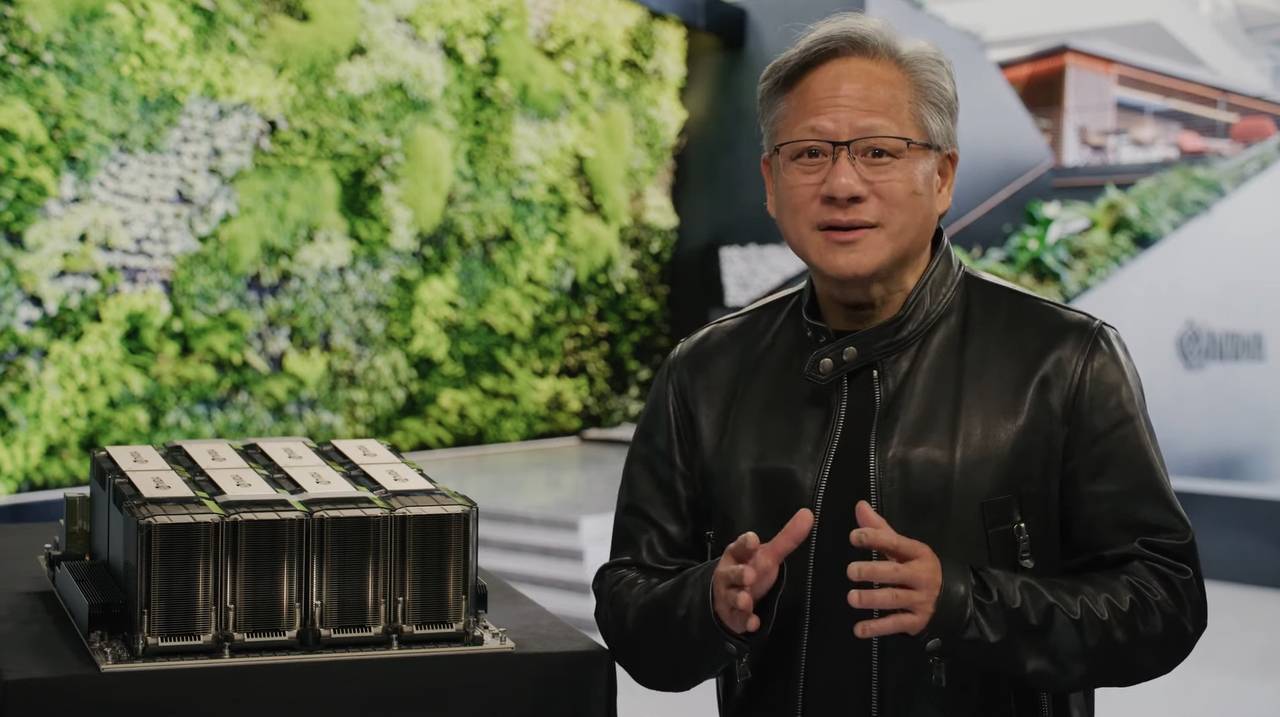

Un altro grande lavoro di Nvidia è spostare il “ChatGPT stesso modello” nel cloud e aprirlo al pubblico.

Il funzionamento di ChatGPT si basa principalmente sul supercomputer DGX composto da A100 o H100 Microsoft ha speso centinaia di milioni di dollari per acquistare decine di migliaia di schede grafiche A100 per formare la piattaforma di cloud computing di Azure.

Per ridurre i costi di distribuzione di modelli di grandi dimensioni per gli utenti, Nvidia ha lanciato il servizio DXG Cloud: a partire da $ 36.999 al mese, è possibile ottenere un supercomputer cloud composto da 8 schede grafiche H100 o A100 per completare facilmente attività di elaborazione ad alto carico.

Nel 2016, Lao Huang ha consegnato personalmente il primo supercomputer DGX a OpenAI. Sette anni dopo, la massima potenza di calcolo AI ha l’opportunità di entrare in ogni azienda attraverso DXG Cloud, portando a termine compiti che in passato erano impossibili.

Non è difficile immaginare che applicazioni avanzate come ChatGPT in grado di migliorare la comunicazione umana e l’efficienza lavorativa continueranno ad emergere, portando più comodità e sorprese nelle nostre vite.

Toccando la pietra nell’oro, la seconda generazione di Runway ti consente di generare tutti i tipi di film di successo in una sola frase

C’è sempre stato uno stalking popolare alla stazione B: i video non possono essere pubblicati, quindi è vero. Ma ora i video non solo possono essere P, ma possono anche essere generati direttamente con l’IA da zero, senza pittori, fotografi o post-elaborazione. Finché inserisci un paragrafo di testo in Runway, ti restituirà un breve video scioccante.

All’inizio, Runway era uno strumento ausiliario di post-produzione.Sebbene utilizzasse il potere magico dell’intelligenza artificiale, ciò che poteva ottenere non era complicato: cancellare oggetti, interpolare immagini, eliminare sfondi, tracciare il movimento, ecc. Plugin Premiere per manichini.

E quando Runway ha aperto una nuova porta all’intelligenza artificiale, ha la capacità di trasformare le pietre in oro. Nella versione Gen 1 annunciata lo scorso settembre, ha la capacità di convertire il testo in video. Le persone a quel tempo avevano appena visto la magia della conversione da testo a immagine e Runway poteva generare direttamente immagini dinamiche, il che era scioccante come un colpo di riduzione della dimensionalità.

Dopo sei mesi, Runway Gen 2 è qui.

Rispetto al modello Gen 1, raggiunge una maggiore coerenza temporale e fedeltà.In termini umani, la connessione tra le immagini è più fluida e la qualità dell’immagine è superiore.

Con Gen 2, sei un passo avanti verso la generazione di video della tua immaginazione sempre e ovunque.

Inserisci una parola pronta non troppo lunga: montagne fotografate dai droni. Sulla base di ciò, Runway genera la seguente schermata.

Eccone un altro: la luce del sole pomeridiano filtra dalle finestre di un appartamento a New York City.

Passa a una versione avanzata, invia immagini e testo a Runway, quindi genera un breve video.

▲ Il testo è: Un uomo cammina per strada, e le luci al neon dei bar circostanti lo illuminano

▲ Immagine originale

O animare un’immagine statica.

È anche possibile eseguire direttamente il rendering di un’immagine dinamica da un’animazione non testurizzata da renderizzare.

Il progresso di Runway è evidente a tutti. È andato sempre più lontano e più agevole sulla strada rispetto al modello di rete. La versione Gen 2 di oggi può essere considerata “guardabile”. Anche se non è squisita, il futuro può essere previsto.

Forse quando si tratta della versione Gen 3, con l’aiuto di essa, possiamo generare brevi video di successo di Douyin con un clic. A quel tempo, sarà un incubo per i blogger di qualità?

Scoppiare! Google avvia i test di Bard

Se Nvidia ci permette di vedere il futuro dello sviluppo dell’IA, allora Bard di Google è l’IA di oggi.

Dopo che tutti sono rimasti scioccati da GPT-4 e Midjourney V5 per una settimana, mentre Lao Huang attendeva con impazienza la futura era dell’IA, Google ha annunciato l’apertura ufficiale dell’accesso di Bard: prova Bard e fornisci il tuo feedback.

Secondo l’ultima demo di Google, Bard è più simile a un assistente personale concentrato sul lavoro e sullo studio che su ChatGPT: con la sua assistenza, puoi stimolare idee e soddisfare la curiosità.

Puoi chiedere a Bard di spiegare la fisica quantistica in un linguaggio semplice o chiedere a Bard di fare un brainstorming e aiutarti a leggere 20 libri in un anno.

Google ha affermato che gli utenti possono accelerare le idee e stimolare la curiosità con l’aiuto di Bard. Puoi usare Bard per dare suggerimenti come leggere 20 libri all’anno o spiegare la fisica quantistica in un linguaggio semplice.

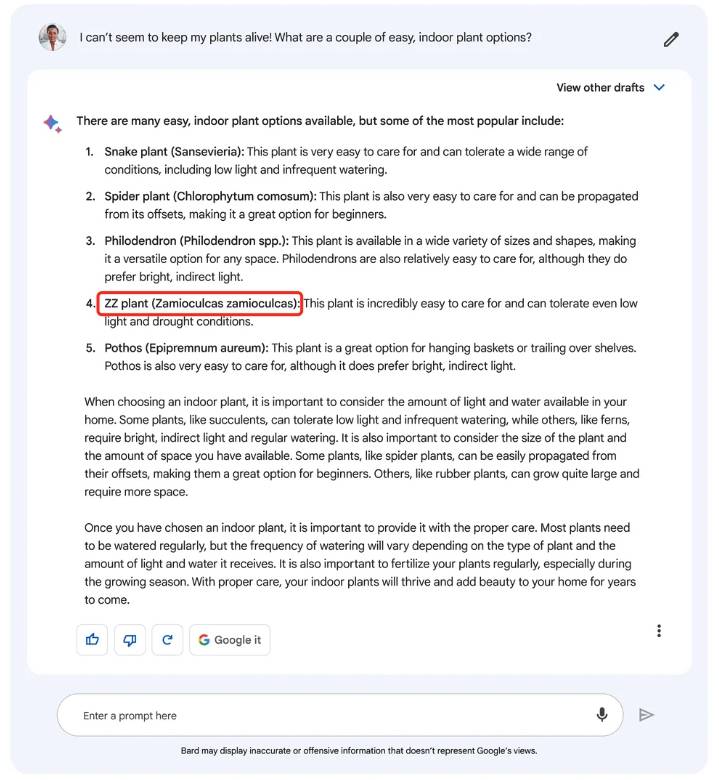

Abbiamo anche trovato alcuni dettagli nel contenuto della demo: Bard sembra generare più risposte contemporaneamente, puoi scegliere quella più adatta a te in base alle tue esigenze e continuare a fare domande.

Naturalmente, ChatGPT può anche generare più risposte, ma viene rigenerato dopo che la risposta è finita.In confronto, Bard è più simile a una parte B che fornirà più soluzioni contemporaneamente.

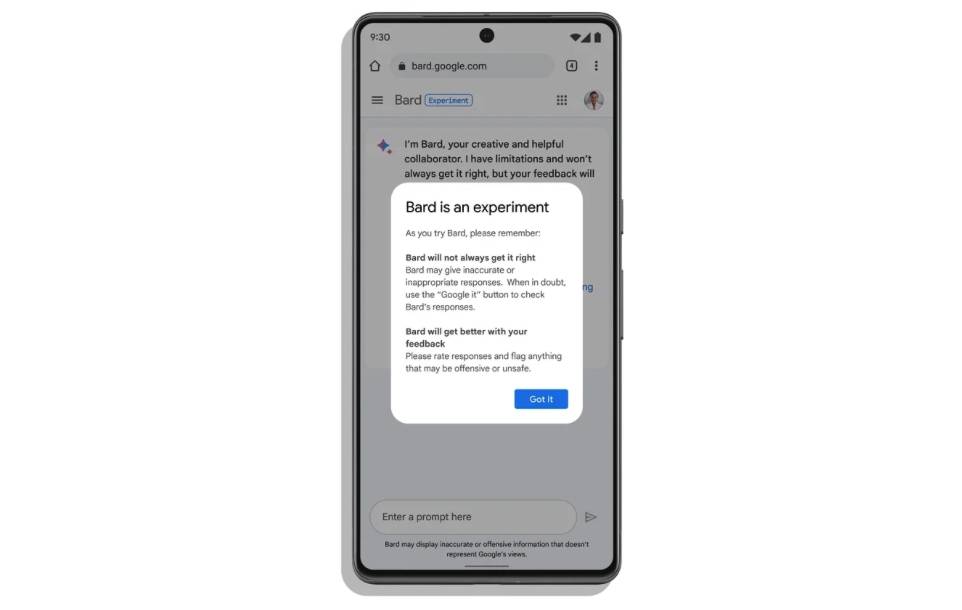

Può darsi che le notizie negative di ChatGPT e Bing Chat abbiano attirato l’attenzione di Google, che sottolinea costantemente che Bard è solo un esperimento, e le informazioni generate da Bard non rappresentano il punto di vista di Google.

Google ha affermato che sebbene Bard sia alimentato da un modello linguistico ampio e diventerà più forte nel tempo, apprenderà alcuni pregiudizi o stereotipi, facendolo dire “con sicurezza” alcune informazioni imprecise o false, ad esempio, capirà “ZZ Plant” come Zamioculcas zamioculcas invece del corretto Zamioculcas zamiifolia.

Con le lezioni apprese dalla “pazza” Chat di Bing, la prima versione beta di Bard limitava il numero di scambi in una stessa conversazione, così da garantire l’accuratezza del contenuto. Quando accedi per la prima volta a Bard, ti dice che si tratta di un esperimento e attende con impazienza il tuo feedback.

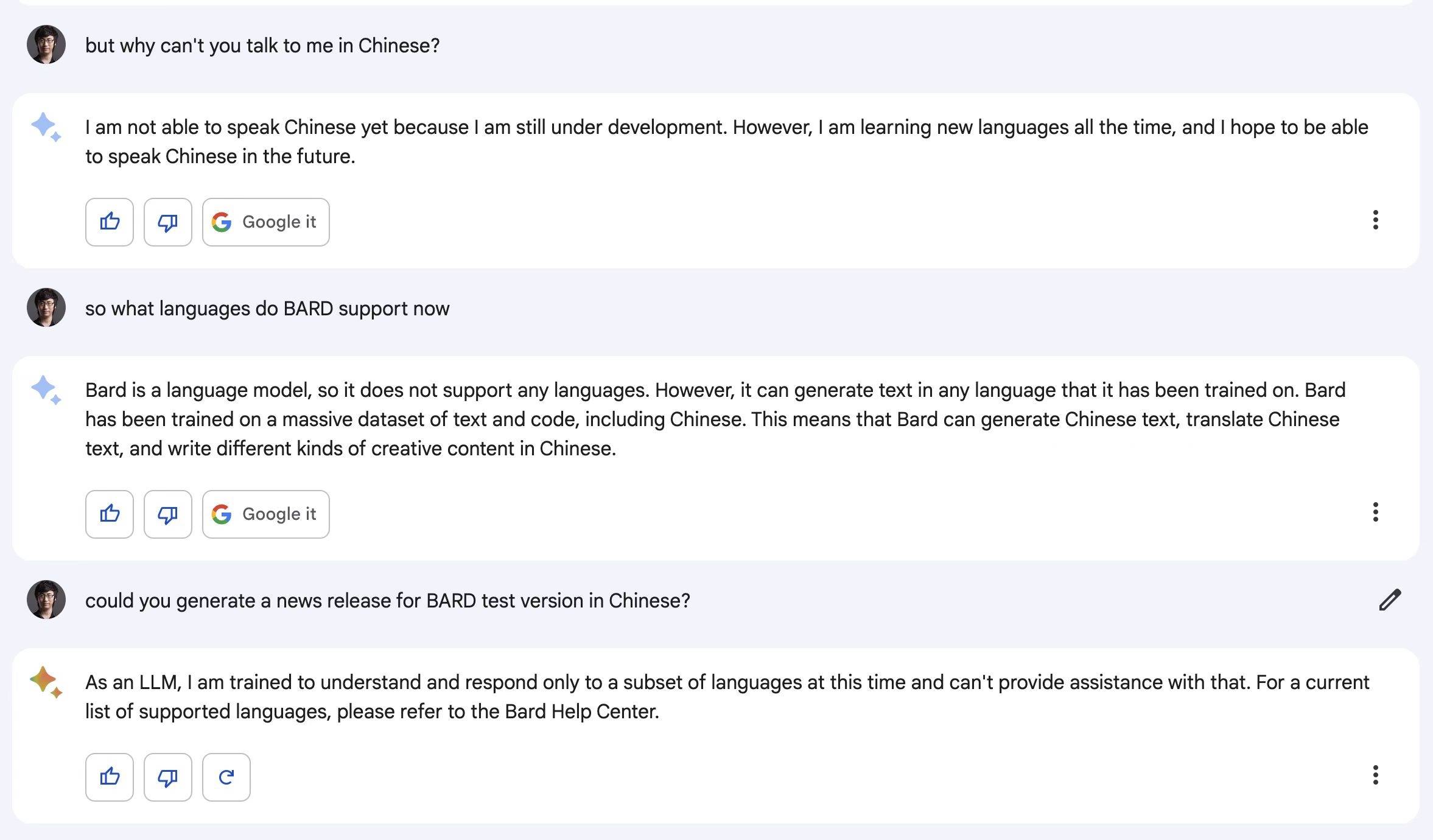

Come prima versione di Bard, non supporta ancora più lingue (incluso il cinese) e Google continuerà ad aggiornare la scrittura del codice, il riconoscimento/generazione di immagini e il supporto multilingue.

▲ Bard: Non conosco il cinese, ma spero di parlare cinese in futuro

Attualmente, Bard è disponibile solo per l’accesso nel Regno Unito e negli Stati Uniti e in futuro si espanderà gradualmente in più paesi e regioni.

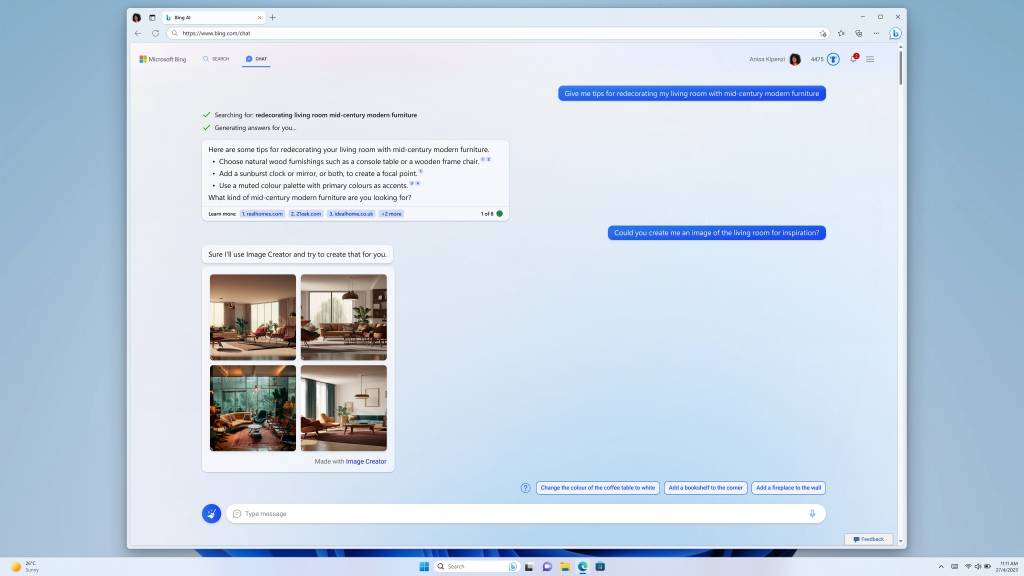

Puoi fare foto mentre chatti, Bing Chat fa un ulteriore passo avanti

Quanto sia popolare Bing Chat, forse solo i dati che Bing DAU ha superato i 100 milioni per la prima volta dopo il suo lancio possono spiegarlo. Da domande complesse a chat divertenti a idee ispirate realizzate, Bing Chat sta rimodellando il modo in cui effettuiamo ricerche sul Web.

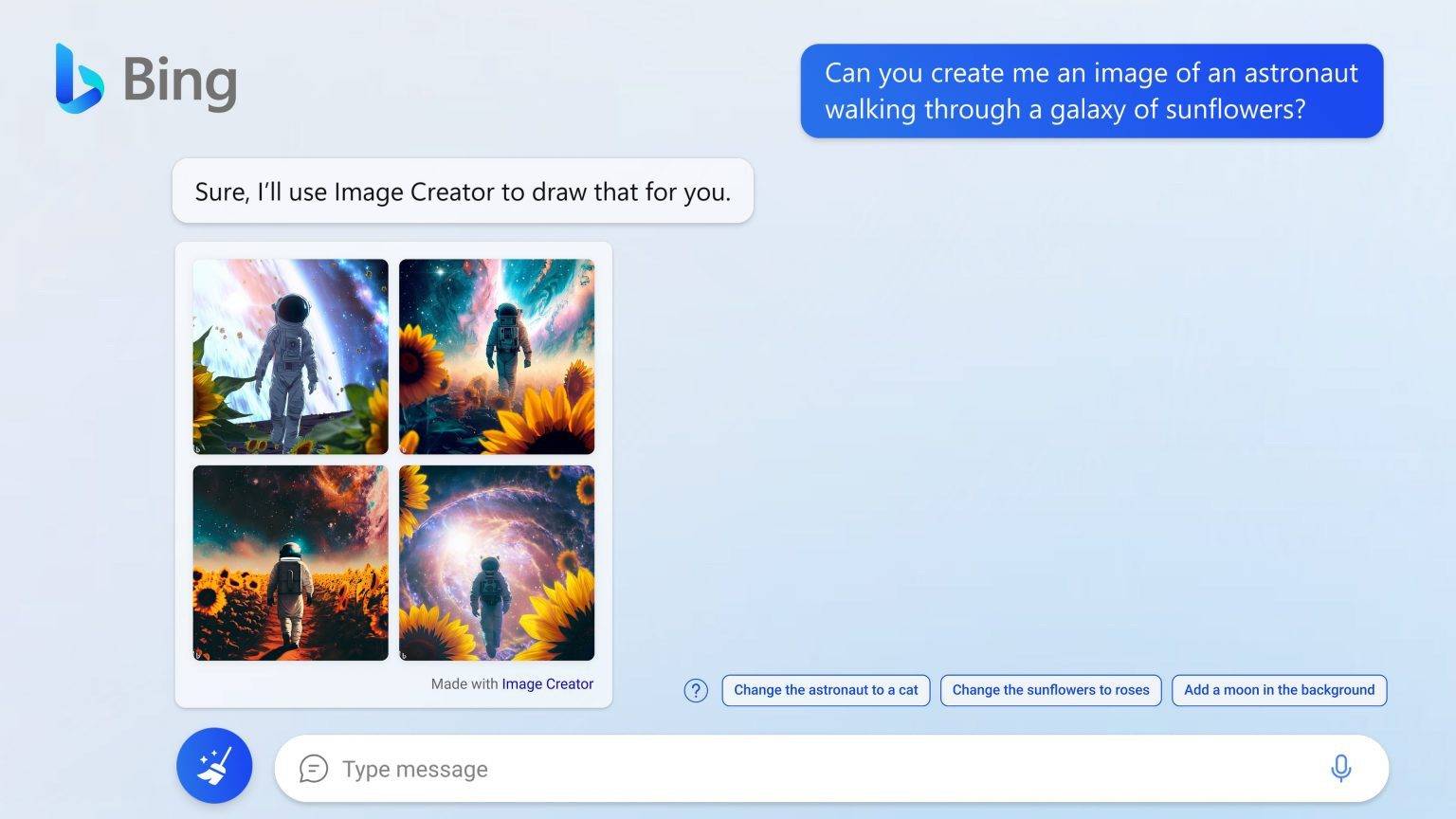

D’ora in poi, puoi chiedere a Bing Chat di disegnare immagini.

Microsoft ha aggiornato le versioni di anteprima dei nuovi browser Bing ed Edge con tre nuove funzionalità: Bing Image Creator, Storie guidate dall’intelligenza artificiale e Schede informative 2.0. Il più importante di questi è Bing Image Creator che può disegnare immagini.

Secondo Microsoft, il cervello umano elabora le informazioni visive circa 60.000 volte più velocemente del testo. Nei dati di ricerca di Bing, le immagini sono uno dei tipi più ricercati. Bing Image Creator, basato su una versione avanzata del modello DALL·E, può Lasciarci usa la nostra lingua per descrivere le informazioni sull’immagine in Bing Chat, seleziona lo stile artistico e Image Creator collegherà il contesto e “disegnerà la tua immaginazione sulla carta”.

L’aggiunta di Bing Image Creator rende il browser Edge il primo browser a integrare un generatore di immagini di intelligenza artificiale.

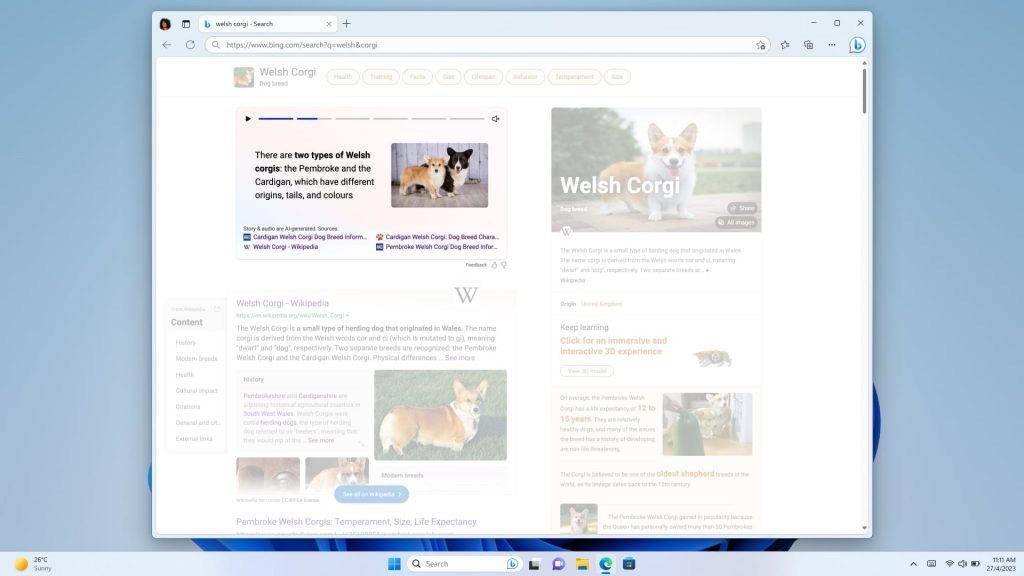

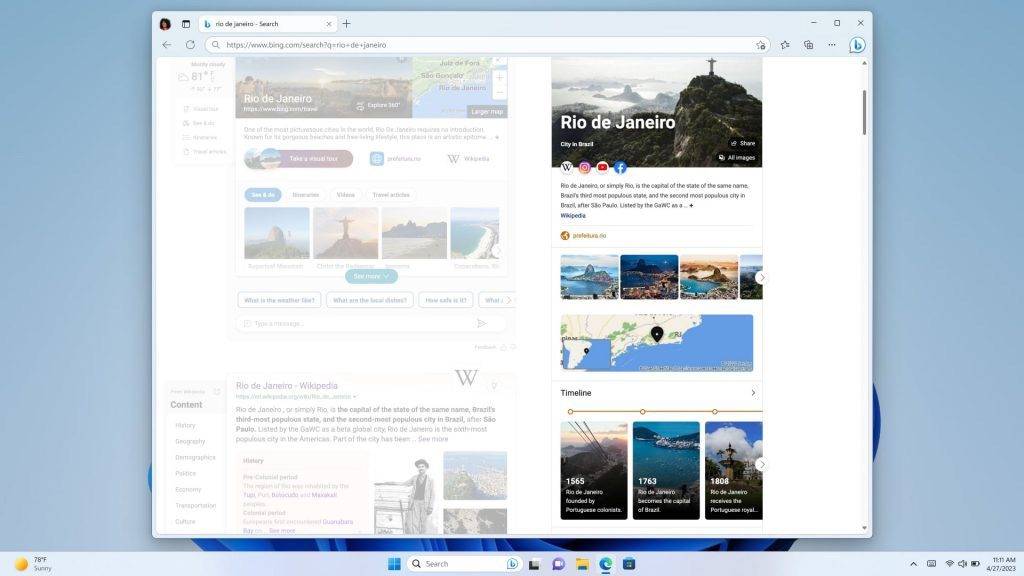

Le storie e le schede informative 2.0 alimentate dall’intelligenza artificiale ti consentono di ottenere immagini, brevi video e infografiche guidate dall’intelligenza artificiale dopo la ricerca e puoi ottenere fatti e informazioni chiave a colpo d’occhio.

Quando utilizzerai Bing per cercare in futuro, ciò che otterrai non saranno freddi collegamenti Web, ma immagini, video e storie visive più ricche e interessanti.

Se hai fatto domanda tramite il nuovo Bing, ora puoi provare Bing Image Creator in Bing Chat e, se accedi dal seguente URL, puoi provarlo direttamente.

https://www.bing.com/create

Tuttavia, questa funzione supporta solo l’inglese per il momento e continuerà ad essere aggiornata in futuro.

Adobe Firefly: “Il più forte supporto tra gli alleati”

Quando le aziende tecnologiche vengono coinvolte nella generazione di immagini, la famosa azienda di design e creatività Adobe non è naturalmente molto indietro. In questa pazza notte, Adobe ha anche lanciato la propria raccolta di modelli di intelligenza artificiale generativa creativa: Adobe Firefly.

Adobe ha dimostrato le capacità di Firefly con alcuni semplici esempi. Puoi usare una frase per trasformare lo scenario in primavera in inverno.

Puoi anche usare un pennello sull’erba per dipingere in modo casuale, quindi dire a Firefly che questo è un fiume e genererà automaticamente un fiume.

Naturalmente, Firefly può fare di più: seleziona i peli di un cane, può trasformarli in una spazzola e aiuta il cane a cambiare pettinatura all’istante, disegna una word art, può aiutarti a generare una parola, una frase; progettare una cuffia, Firefly può anche metterla in scena e trasformarla in un display di prodotto…

Adobe ritiene che l’intelligenza artificiale stia fornendo un nuovo modo per aprire il mondo e che i designer possano utilizzare il modo più conveniente per realizzare la creatività, “aiutando le persone creative piuttosto che sostituirle”.

Allo stesso tempo, Adobe ha anche creato la “Content Authenticity Initiative” CAI, che ha stabilito uno standard globale per l’attribuzione di contenuti digitali affidabili e ha contrassegnato i contenuti generati dall’intelligenza artificiale per creare l’ecosistema Firefly. Il supporto più forte”.

Attacco all’AIGC

Durante questa notte, abbiamo assistito a diversi importanti progressi nel campo dell’IA, dal livello del servizio al livello dell’applicazione.

Questi aggiornamenti raggruppati dimostrano dal lato che il campo dell’IA è entrato in una fase di rapido sviluppo. Il mese scorso, l’IA potrebbe non essere in grado di disegnare bene le dita.Il mese prossimo, con l’aumento della potenza di calcolo e gli aggiornamenti dei modelli, l’IA può già sostituire il lavoro dei modelli di abbigliamento.

Innumerevoli opere di fantascienza hanno predetto che l’IA diventerà parte delle nostre vite in futuro, ma nessuno ci ha detto che siamo solo a pochi passi da questo futuro.

Le nostre vite vengono riscritte poco a poco dall’intelligenza artificiale. Alla conferenza GTC, Huang Renxun ha presentato un punto di vista interessante: crede che l’IA generativa sia un nuovo tipo di computer: possiamo programmare in linguaggio umano e chiunque può ordinare al computer di risolvere i problemi.

Negli ultimi mesi abbiamo assistito a come l’IA abbia gradualmente acquisito padronanza di abilità come disegno, scrittura, editing, tabulazione e PPT.Se questa velocità evolutiva continua, c’è qualcosa che l’IA non può fare?

Il CEO di OpenAI, Sam Altman, ha recentemente coraggiosamente predetto su Twitter una nuova versione della “Legge di Moore”, ritenendo che la quantità di calcolo dell’intelligenza artificiale globale raddoppierà ogni 18 mesi.

In altre parole, se hai ancora dubbi sull’IA generativa, allora il tempo ti darà la risposta più potente.

#Benvenuti a prestare attenzione all’account pubblico WeChat ufficiale di Aifaner: Aifaner (ID WeChat: ifanr), altri contenuti interessanti ti verranno presentati il prima possibile.

Ai Faner | Link originale · Visualizza i commenti · Sina Weibo