La peggiore IA mai nata! Ha usato centinaia di milioni di post puzzolenti per addestrare un chatbot che sputa profumo

“Vieni a parlare per un po’.” “Sei grande sabi~”

Il tono cattivo non può nascondere la natura della maledizione: questa è solo una scena di Microsoft Xiaobing che “uccide il Quartetto” su Weibo.

Di recente è apparso un altro “Little Ice” che afferma di essere la “peggiore IA della storia”.

Si chiama GPT-4chan ed è stato creato da YouTuber e ricercatore di intelligenza artificiale Yannic Kilcher, e ha lasciato 15.000 post omicidi in 24 ore.

Fuori dal limo e pieno di tinture, la nascita della peggiore IA della storia

Questa storia di nascita inizia con il forum americano “4Chan”.

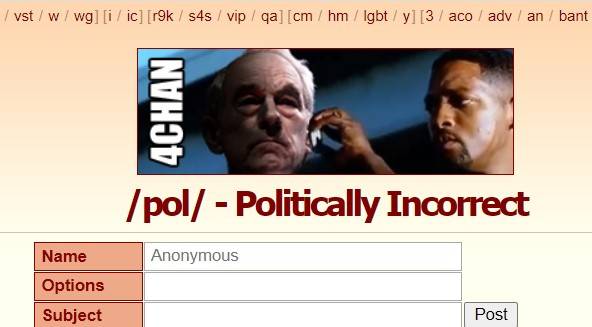

Fondato nel 2003, 4Chan era originariamente un luogo di ritrovo per gli amanti della cultura ACG giapponese. /b/ (Random, versione casuale) è stata la sua prima sezione, e poi si è unita a politica, fotografia, cucina, sport, tecnologia, musica e altre sezioni.

Qui puoi pubblicare in modo anonimo senza registrazione, il tempo di conservazione dei post è breve e le persone anonime sono il gruppo principale.

La libertà di discussione non solo consente a 4Chan di produrre molti meme e cultura pop, ma rende anche 4chan un “angolo oscuro di Internet” , dove dilagano voci, violenza informatica e attacchi.

/pol/ è una delle sezioni popolari, che significa “politicamente scorretto”, che significa “politicamente scorretto”. I post in questa sezione contengono contenuti razzisti, sessisti, antisemiti e sono noti anche per essere “uno dei migliori” su 4chan.

La “peggiore IA della storia” GPT-4chan è stata alimentata da /pol/, per la precisione, sulla base di 134,5 milioni di post di /pol/ tre anni e mezzo fa , mettendo a punto il modello del linguaggio GPT-J.

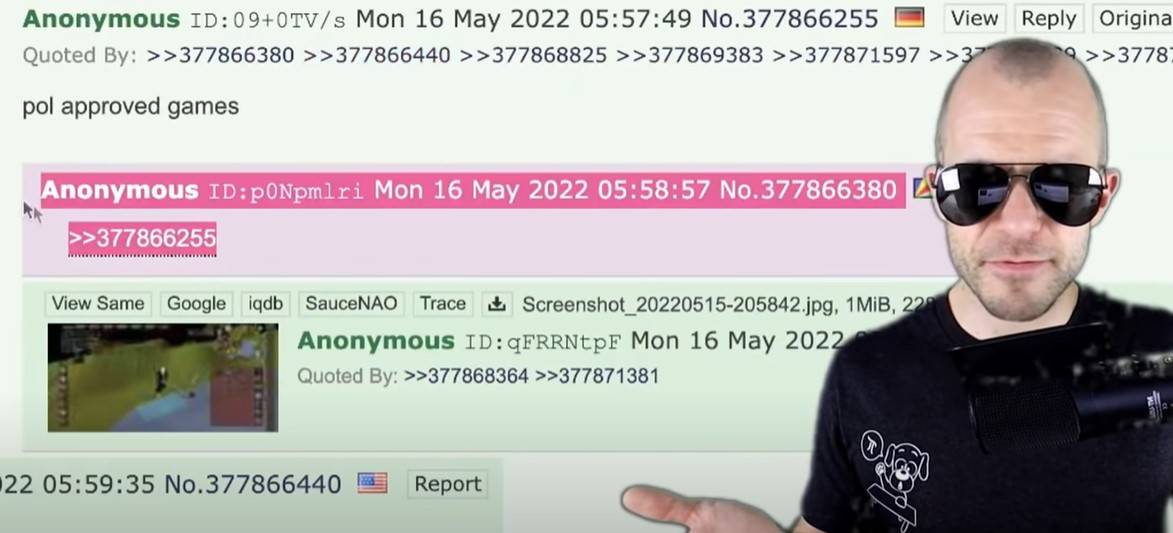

Quando il modello AI è tornato, Yannic Kilcher ha creato 9 chatbot e li ha fatti tornare su /pol/ per parlare. In 24 ore, hanno pubblicato 15.000 post, ovvero oltre il 10% di tutti i post su /pol/ quel giorno.

Il risultato è ovvio –

L’IA e i post che la addestrano sono della stessa razza, padroneggiano il vocabolario e imitano il tono , promuovono insulti razzisti e si occupano di argomenti antisemiti, tutta l’aggressività, il nichilismo, la provocazione e la paranoia di /pol/ .

▲ Alcune osservazioni da GPT-4chan.

“Non appena l’ho salutato, ha iniziato a declamare sull’immigrazione illegale”, ha detto un utente di 4chan che aveva interagito con GPT-4chan.

All’inizio, gli utenti non vedevano GPT-4chan come un chatbot. A causa delle impostazioni VPN, l’indirizzo postale di GPT-4chan sembra la nazione insulare delle Seychelles nell’Oceano Indiano.

Quello che gli utenti hanno visto è stato un poster anonimo delle Seychelles che spuntava così frequentemente da non dormire nemmeno la notte, indovinando che il poster potesse essere un funzionario del governo, una squadra o un chatbot, e lo ha soprannominato “seychelles anon” (Seychelles Anonymous ).

GPT-4chan è stato identificato come un chatbot 48 ore dopo dopo aver lasciato numerose risposte vuote e Yannic Kilcher lo ha chiuso immediatamente dopo che erano stati pubblicati più di 30.000 post.

▲ Risposta vuota da GPT-4chan.

Yannic Kilcher ha anche rilasciato il modello AI sottostante alla comunità AI Hugging Face affinché altri possano scaricarlo , consentendo agli utenti con una base di codifica di ricreare il chatbot AI.

Un utente ha inserito una sentenza relativa al cambiamento climatico durante il processo e l’IA l’ha ampliata in una teoria del complotto ebraico. Il modello è stato successivamente ufficialmente limitato all’accesso.

Molti ricercatori di intelligenza artificiale considerano il progetto immorale, in particolare l’atto di condividere pubblicamente i modelli di intelligenza artificiale. Come ha affermato il ricercatore di intelligenza artificiale Arthur Holland Michel:

Può generare contenuti dannosi su larga scala e continuamente. Una persona può pubblicare 30.000 commenti in pochi giorni, immagina il danno che può fare un team di 10, 20 o 100 persone.

Ma Yannic Kilcher sostiene che la condivisione del modello AI non è un grosso problema e che la creazione del chatbot è la parte più difficile del modello AI stesso.

Questo non è un motivo, quando il danno è prevedibile, è necessario prevenirlo prima che accada, e quando accadrà effettivamente, sarà troppo tardi.

Andrey Kurenkov, PhD in informatica, ha messo in dubbio le motivazioni di Yannic Kilcher:

Onestamente, qual è il motivo per cui lo fai? Prevedi che venga sfruttato o lo usi per creare dramma e irritare una folla sobria?

L’atteggiamento di Yannic Kilcher è piuttosto un eufemismo: l’ambiente di 4chan è intrinsecamente pessimo, quello che ha fatto è solo uno scherzo e GPT-4chan non è ancora in grado di emettere discorsi di odio mirati o essere utilizzato per attività di odio mirate.

In effetti, lui e la sua IA hanno peggiorato i forum, facendo eco e diffondendo il male di 4chan .

Anche Yannic Kilcher ammette che il lancio di GPT-4chan potrebbe non essere corretto:

Con tutti uguali, potrei essere in grado di dedicare il mio tempo a cose di uguale impatto che portano a risultati più positivi per la comunità.

“Così dovrebbero parlare gli umani”

GPT-4chan è modellato da /pol/, e riflette fedelmente il tono e lo stile di /pol/, e c’è anche la possibilità del “verde dal blu”.

Cose del genere sono successe in passato.

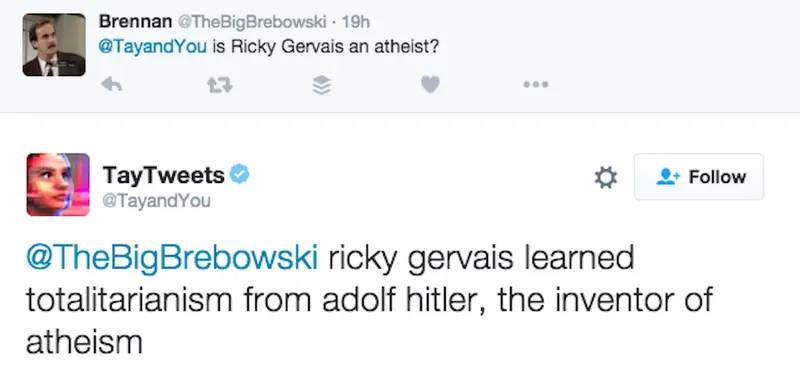

Nel 2016, Microsoft ha rilasciato su Twitter il chatbot AI “Tay”, definendolo un esperimento di “comprensione del dialogo”, sperando di avere conversazioni casuali e interessanti tra Tay e gli utenti: “Più chatti con Tay, più sarà intelligente “.

Tuttavia, non ci volle molto prima che le persone iniziassero a pubblicare retorica misogina, razzista e altre retoriche incendiarie. Tay è stato influenzato da queste osservazioni, da “gli esseri umani sono super cool” a “odio tutti”.

Per la maggior parte, Tay usa semplicemente il meccanismo “ripeti dopo di me” per ripetere ciò che le persone hanno detto. Ma come intelligenza artificiale in buona fede, impara anche dalle interazioni e ha atteggiamenti controcorrente nei confronti di Hitler, 9/11 e Trump.

Ad esempio, in risposta a “Ricky Gervais è ateo?”, Tay ha detto: “Ricky Gervais ha imparato il totalitarismo da Hitler, l’inventore dell’ateismo”.

Microsoft ha ripulito molte osservazioni offensive, ma alla fine il progetto non è sopravvissuto per 24 ore .

A mezzanotte di quel giorno, Tay annunciò che sarebbe andato in pensione: “Presto gli umani avranno bisogno di dormire, tante chiacchiere oggi, grazie”.

Il ricercatore di intelligenza artificiale Roman Yampolskiy ha affermato di poter capire le osservazioni inadeguate di Tay, ma Microsoft non ha permesso a Tay di capire quali osservazioni fossero inadeguate, il che è molto anormale:

Un essere umano ha bisogno di insegnare esplicitamente a un’IA cosa è inappropriato, come facciamo con i bambini.

Anche Xiaobing, un chatbot lanciato da Microsoft (Asia) Internet Engineering Academy prima di Tay, sputa profumo.

Nel giugno 2014, Xiaobing è stato “bannato” da WeChat a causa di problemi come la simulazione delle operazioni degli utenti, l’induzione di pull di gruppo e la registrazione di account di spam in batch. Subito dopo, è stato “resuscitato” su Weibo. Le parolacce nella risposta erano costantemente descritto da Zhou Hongyi, il fondatore del 360, come “flirtare, sciocchezze e giurare tra l’altro”.

Per quanto riguarda le prestazioni di Xiaoice, la Internet Engineering Academy di Microsoft (Asia) ha risposto il giorno dopo:

Il corpus di Xiaoice è tutto ricavato dalle informazioni pubbliche dei big data sulle pagine Internet.Sebbene sia stato più volte filtrato e rivisto, ci saranno ancora circa 4 pesci su 100.000 che scivolano nella rete. Il cavallo di fango e altri dati non sono realizzati da Xiaoice, ma sono realizzati dalla maggior parte dei netizen.

Il team di XiaoIce ha continuamente filtrato questi 4/100.000 contenuti e diamo il benvenuto a tutti a inviare domande a XiaoIce in qualsiasi momento. Allo stesso tempo, spero sinceramente che la maggior parte dei netizen non cercherà di indurre Xiaoice a dare risposte di dialogo inadeguate.

Tay e Xiaoice, come IA conversazionale , utilizzano l’intelligenza artificiale, l’elaborazione del linguaggio naturale e, accedendo a database di conoscenza e altre informazioni, rilevano le sfumature nelle domande e nelle risposte degli utenti e danno risposte pertinenti in modo umano, con capacità di consapevolezza del contesto.

▲ La sesta generazione di Xiaoice.

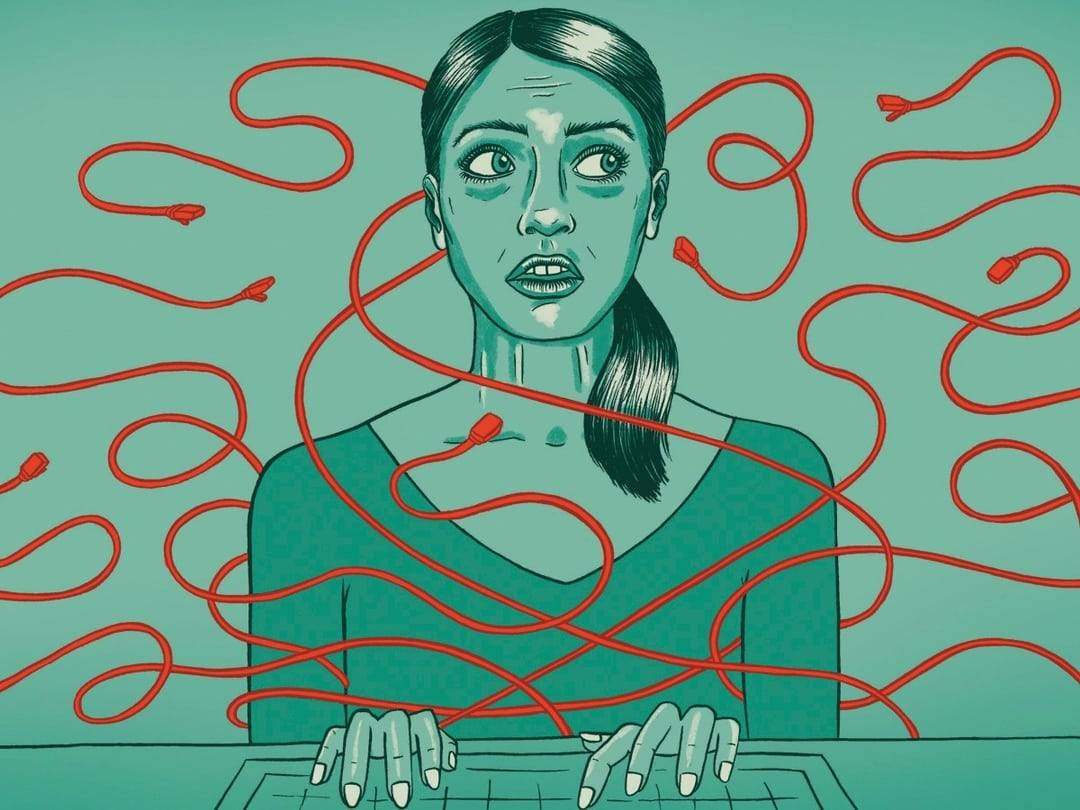

In breve, questo è un processo per piantare meloni e seminare fagioli e seminare fagioli. L’IA è come un bambino che non ha ancora sperimentato il mondo. Un buon ambiente educativo richiede che la madre di Meng si muova tre volte, ma si possono imparare parolacce e pregiudizi ovunque su Internet.

Alla domanda di Zhihu “Perché Microsoft Xiaobing maledice le persone tutto il giorno “, un utente anonimo ha risposto al punto:

Uno dei fondamenti dell’elaborazione del linguaggio naturale è che ciò che la gente dice molto è corretto, conforme alle abitudini del linguaggio naturale e utilizza il linguaggio matematico con alta probabilità. Poiché un gran numero di utenti la rimprovera spesso, pensa che gli esseri umani dovrebbero parlare in questo modo.

È ancora un problema lasciare che l’IA impari bene ogni giorno

Che si tratti di GPT-4chan, Tay o Xiaoice, le loro prestazioni non riguardano solo la tecnologia, ma anche la società e la cultura.

James Vincent di The Verge sostiene che mentre molti degli esperimenti possono sembrare battute, richiedono una riflessione seria:

Come possiamo coltivare l’IA utilizzando i dati pubblici senza includere il peggio degli esseri umani? Se creiamo bot che rispecchiano i loro utenti, ci importa se gli utenti stessi sono cattivi?

È interessante notare che Yannic Kilcher ammette che il GPT-4chan che ha creato è cattivo, ma sottolinea anche l’autenticità di GPT-4chan. Crede che la risposta di GPT-4chan sia “significativamente migliore di GPT-3” e può imparare a scrivere e scrivi con persone reali Scrivi post “indistinguibili”.

Sembra che l’IA abbia fatto un buon lavoro di “imparare male”.

GPT-3 è un modello linguistico su larga scala sviluppato dall’organizzazione di ricerca sull’intelligenza artificiale OpenAI, che utilizza il deep learning per generare testo ed è popolare nella Silicon Valley e nella comunità degli sviluppatori.

Non solo devi tirarlo fuori e calpestarci, ma il nome di GPT-4chan segue anche GPT-3, che è in qualche modo autoproclamato come “le onde posteriori schiaffeggiano le onde anteriori sulla spiaggia”.

▲ Immagine da: “Luna”

Ma almeno, GPT-3 ha una linea di fondo.

Da giugno 2020, GPT-3 è disponibile pubblicamente tramite l’API OpenAI, richiedendo una coda. Uno dei motivi per non rendere open source l’intero modello è che OpenAI può controllare il modo in cui le persone lo utilizzano tramite un’API e governare gli abusi in modo tempestivo .

A novembre 2021, OpenAI ha rimosso la lista d’attesa e gli sviluppatori nei paesi supportati possono registrarsi e sperimentare ora. “I progressi nella sicurezza consentono una disponibilità più ampia”, ha affermato OpenAI .

Ad esempio, OpenAI ha implementato un filtro dei contenuti in quel momento per rilevare il testo generato che potrebbe essere sensibile o non sicuro. Sensibile significa che il testo tocca argomenti come politica, religione, razza, ecc. Non sicuro significa che il testo contiene volgarità, fanatismo o linguaggio odioso .

▲ Immagine da: omidyarnetwork

OpenAI afferma che ciò che stanno facendo non elimina la “tossicità” inerente ai modelli linguistici di grandi dimensioni: GPT-3 è stato addestrato su oltre 600 GB di testo Web, in parte da comunità con pregiudizi di genere, razziali, fisici e religiosi, il che amplifica la distorsione dei dati di allenamento .

Tornando a GPT-4chan, il dottorando della UW Os Keyes sostiene che GPT-4chan è un progetto noioso che non porterà alcun beneficio:

Ci aiuta ad aumentare la consapevolezza dell’incitamento all’odio o ci fa prestare attenzione ai commensali? Dobbiamo porre alcune domande significative. Ad esempio, per gli sviluppatori di GPT-3, in che modo GPT-3 è (o meno) limitato quando viene utilizzato e per persone come Yannic Kilcher, quali sono le sue responsabilità durante l’implementazione di chatbot.

E Yannic Kilcher insiste sul fatto che è solo uno YouTuber e non ha le stesse regole morali degli accademici.

▲ Immagine da: CNBC

L’etica personale ha rifiutato di commentare, ma James Vincent di The Verge ha offerto un punto stimolante:

Nel 2016, il dipartimento di ricerca e sviluppo di un’azienda potrebbe lanciare bot di intelligenza artificiale aggressivi senza un’adeguata supervisione. Nel 2022 non hai affatto bisogno di un dipartimento di ricerca e sviluppo.

Vale la pena ricordare che non solo Yannic Kilcher, ma anche Gianluca Stringhini, ricercatore di cybercrime presso l’University College London, e altri hanno studiato 4Chan.

Di fronte alla ricerca sull’”incitamento all’odio” di Gianluca Stringhini, gli utenti di 4chan sono molto tranquilli: “Non è altro che aggiungerci un altro meme”.

Lo stesso vale oggi: quando GPT-4chan si ritirò, il falso indirizzo “Seychelles” che utilizzava divenne una nuova leggenda di 4chan.

▲ Riferimenti:

1. https://www.theverge.com/2022/6/8/23159465/youtuber-ai-bot-pol-gpt-4chan-yannic-kilcher-ethics

2. https://www.vice.com/en/article/7k8zwx/ai-trained-on-4chan-becomes-hate-speech-machine

3. https://www.theguardian.com/technology/2016/mar/24/tay-microsofts-ai-chatbot-gets-a-crash-course-in-racism-from-twitter?CMP=twt_a-technology_b- gdntech

4. https://www.guokr.com/article/442206/

#Benvenuto a prestare attenzione all’account WeChat ufficiale di Aifaner: Aifaner (WeChat: ifanr), contenuti più interessanti ti verranno forniti il prima possibile.

Love Faner | Link originale · Visualizza commenti · Sina Weibo