Contrattaccare! Ha debuttato la versione Google di ChatGPT, con una funzione per “rullare” ChatGPT

Si può dire che Google sia una delle aziende più esperte di IA al mondo. Ha sconfitto il campione mondiale di Go with AI, ha tradotto 133 lingue e ha spinto gli smartphone alla fotografia computazionale. Quasi tutti i prodotti Google sono guidati dall’IA .

Ma negli ultimi due mesi, Google è stato messo in ombra dal chatbot ChatGPT di OpenAI.

ChatGPT, che può parlare come un essere umano, ha completamente tolto la parola AI dal cerchio e la discussione delle persone sull’IA è gradualmente cambiata da “cosa può fare l’IA” a “cos’altro non può fare l’IA”.

Proprio ieri, Microsoft ha annunciato che collaborerà con OpenAI per offrire una nuova versione della ricerca Bing e del browser Edge con chatbot integrati, utilizzando l’intelligenza artificiale per offrire una nuova esperienza di ricerca.

Il significato di Microsoft è chiaro: vuole sfidare lo status di Google come “leader della ricerca” e competere con le migliori mosse dell’altra parte.

Google, che detiene LaMDA, PaLM, Imagen e altre tecnologie AI, naturalmente non permetterà a Microsoft di cogliere così facilmente l’opportunità delle applicazioni AI.

Alla conferenza Google appena conclusa, Google ha dimostrato la nuova tecnologia AI che verrà applicata a Google Lens, mappe, traduzione e soprattutto ricerca in futuro, cercando di rioccupare gli altopiani AI.

Tra questi, il robot di chat Bard esposto insieme è il più potente contrattacco contro ChatGPT, che dichiara anche che il motore di ricerca sta per entrare nell’era delle guerre di chat robot. Ora, nessuno andrà dolcemente in quella buona notte.

Bardo da non sottovalutare

Prima di introdurre Bard, potremmo anche comprendere brevemente il modello LaMDA che utilizza.

Il modello LaMDA rilasciato da Google due anni fa ha attirato un’enorme attenzione nel settore e la sua influenza non è inferiore a quella di ChatGPT oggi.

LaMDA è una nuova architettura AI che rende il machine learning più semplice, più efficiente e più scalabile. Può scalare fino a migliaia di nodi e supporta molti tipi di attività di apprendimento automatico come il riconoscimento delle immagini, l’elaborazione del linguaggio naturale e altro ancora.

Attraverso la formazione, LaMDA può parlare con persone con un’espressione e una comprensione quasi umane. Poiché LaMDA si comportava in modo così simile a un essere umano durante la chat, un ingegnere di Google ha persino pensato che avesse “autocoscienza” e ha suscitato molto scalpore.

Anche questo è uno dei motivi per cui Google non ha colto l’occasione dei chatbot in questo lasso di tempo: non è che sia incapace di farlo, ma che LaMDA è “pazza” e anche Google stessa ne avrà paura.

Tuttavia, Google continuava a sottovalutare l’accettazione dell’AIGC da parte delle persone.L’improvvisa popolarità di ChatGPT ha lanciato l’allarme per Google, così è nato Bard.

Prima del lancio, il CEO di Google Sundar Pichai (Sundar Pichai) aveva già annunciato l’esistenza di Bard sul suo blog.

Bard funziona su una versione leggera del modello LaMDA, che secondo Google riduce la quantità di potenza di calcolo di cui Bard ha bisogno, consentendogli di adattarsi a più utenti e ottenere più feedback.

A differenza di ChatGPT, che è bloccato nel 2021, Bard accetta informazioni dall’ultimo Internet, quindi Bard può fornire risposte a ciò che sta accadendo ora.Confrontando la quantità di informazioni che possono essere recuperate dai due, Bard è una quantità maggiore della classe ChatGPT.

In altre parole, Ai Faner non dovrebbe rimanere alzato fino a tardi per le bozze del codice per le conferenze stampa in futuro, e chiedere semplicemente a Bard di produrre un riassunto della conferenza.

Secondo il display di Google alla conferenza stampa, gli utenti possono porre direttamente domande a Bard in linguaggio naturale, invece di cercare con parole chiave come in passato.

Se desideri acquistare una nuova auto, puoi chiedere direttamente a Bard quale tipo di auto è adatta alla tua famiglia e Bard ti darà diversi suggerimenti per l’acquisto di auto dal punto di vista del budget e della sicurezza.

Se preferisci i nuovi veicoli energetici, Bard ti darà anche suggerimenti per nuovi tipi di energia nel contesto.

Questa è anche la caratteristica di Bard: rispondere alle domande da più angolazioni e una forte capacità di comprensione del contesto.

In futuro, Bard sarà integrato anche nella Ricerca Google per fornirti risposte più rapidamente.

Ad esempio, se cerchi la domanda “Qual è la migliore costellazione che puoi vedere quando osservi le stelle?” nel display Demo di Google, Bart mostrerà le caratteristiche di più costellazioni e il metodo di osservazione.

Google ritiene che l’intelligenza artificiale non abbia una risposta univoca corretta (No One Right Answer) quando risponde alle domande. Pertanto, Bard risponde alle domande degli utenti da più angolazioni e aiuta gli utenti a comprendere rapidamente la situazione generale, piuttosto che fornire una sola risposta univoca come ChatGPT È meglio avere una risposta corretta, apparentemente corretta.

A giudicare dalla demo rilasciata da Google, Bard non è tanto un chat robot quanto un assistente di ricerca costo di ricerca.

Per quanto riguarda il fatto che Bard abbia la potente capacità di generazione di testo come ChatGPT, è ancora difficile giudicare dal display limitato.

Ecco la domanda che preoccupa maggiormente gli utenti: quando sarà disponibile Bard? Google ha dichiarato che Bard è ancora in fase di beta interna e sarà aperto al pubblico nelle prossime settimane, in quel momento anche Ai Faner lo sperimenterà per la prima volta.

Google Translate utilizzato da 1 miliardo di persone

Google Translate potrebbe essere uno dei prodotti più utilizzati di Google oltre alla ricerca. Secondo i dati rilasciati da Google, più di 1 miliardo di persone in tutto il mondo utilizzano Google Translate per comprendere questo mondo variegato.

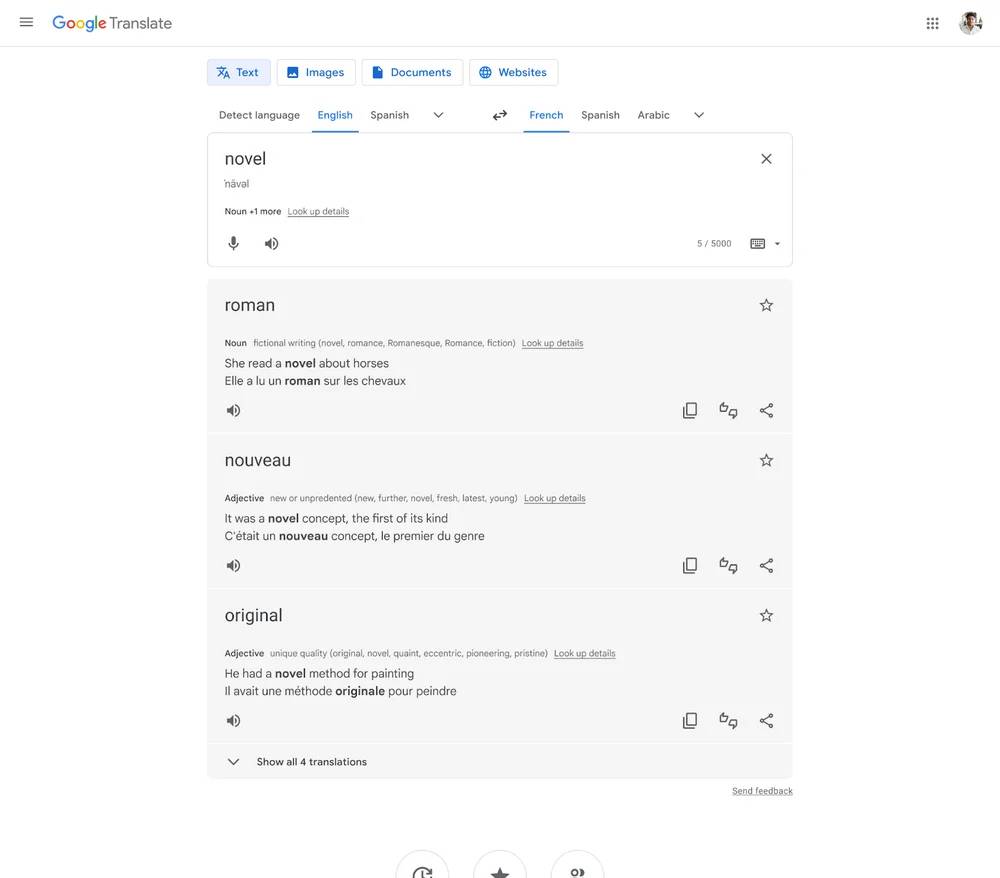

Al fine di aiutare le persone a comprendere meglio e utilizzare lingue straniere sconosciute, Google Translate ora non solo fornisce la traduzione di parole, ma fornisce anche più informazioni di base e pertinenti, come la visualizzazione di più sinonimi, frasi di esempio, ecc. allo stesso tempo.

La funzione sarà disponibile in cinque lingue: inglese, francese, tedesco, giapponese e spagnolo e dovrebbe essere disponibile nelle prossime settimane.

Google Translate sul lato Android utilizzerà anche un nuovo design più leggibile e più facile da usare.La logica di funzionamento più semplice rende la traduzione sempre più facile e puoi gestirla con calma quando incontri barriere linguistiche quando sei lontano da casa. Google ha affermato che in futuro riprogetterà anche Google Translate sul lato iOS.

Un’altra funzione importante dell’aggiornamento di Google Translate è utilizzare la capacità di apprendimento AI per tradurre in modo più accurato il testo in lingua straniera sulle immagini e remixare il testo tradotto e lo sfondo dell’immagine in una nuova immagine, che è migliore della funzione di testo live di iOS. , Google sottolinea che per implementare questa funzione sono necessari più di 6 GB di RAM.

sposta la terra verso la nuvola

La funzione Immersive View annunciata già nel 2021 ha ora un modello architettonico più dettagliato e l’intervallo di rendering è ampio, spostando davvero l’intera terra sul cloud. Allo stesso tempo, Immersive View combina anche il sistema meteorologico, che renderà l’ambiente in base alle previsioni del tempo, che è pieno di immersione.

A partire da oggi, la funzione sarà disponibile a Londra, Los Angeles, New York, San Francisco e Tokyo, con altre città che seguiranno nei prossimi mesi.

Vedendo questa dimostrazione, annuncio unilateralmente che “Earth OL” sarà lanciato ufficialmente oggi. Anche se questo è solo uno scherzo, è davvero un grande miglioramento per la traccia Metaverse.

Un altro “progetto infrastrutturale” del metaverso è la combinazione organica di mondo reale ed elementi virtuali, spesso chiamata “realtà aumentata”. Anche Google Map è curato, ma al momento è utilizzato solo sui telefoni cellulari.

Per strada, sollevi il cellulare e ti guardi intorno, il nome del negozio verrà visualizzato sullo schermo, fai clic su uno dei negozi e puoi visualizzare il contenuto inclusi orari di lavoro, valutazioni dei clienti e recensioni.

Questo non è considerato innovativo, ma le città che supportano questa funzione si stanno gradualmente espandendo e alla fine il ponte tra virtuale e realtà sarà ufficialmente completato. Fino ad allora, non sarà difficile ottenere un’esperienza simile con gli occhiali AR.

Forse in quel momento, Google Glass verrà resuscitato per completare il suo lavoro incompiuto.

Google ha anche annunciato durante la conferenza stampa che la funzione di navigazione AR di Google Map supporterà più di 1.000 aeroporti in tutto il mondo, rendendo più facile per i viaggiatori trovare le loro destinazioni in modo più accurato.

Inoltre, Google ha finalmente iniziato a prestare attenzione ai proprietari di auto a nuova energia: per i veicoli a nuova energia con funzione Google Map integrata, lancerà in futuro la funzione di raccomandazione delle stazioni di ricarica, che è una buona notizia per gli utenti di auto elettriche. Tuttavia, le case automobilistiche nazionali e i fornitori di servizi di mappe hanno già lanciato funzioni simili e le funzioni sono abbastanza complete, Google deve ancora seguire questo aspetto.

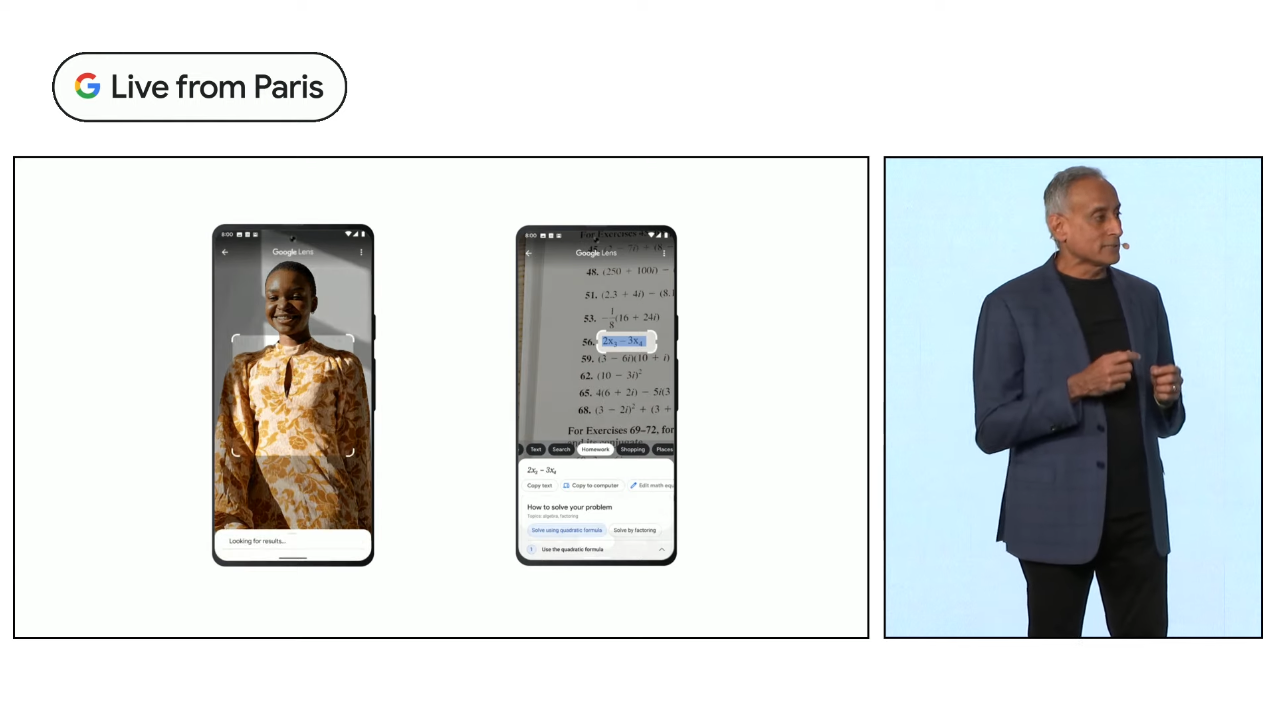

Google Lens, quanto di meglio si possa

Prima della combinazione di intelligenza artificiale e fotocamere, gli obiettivi dei telefoni cellulari potevano essere utilizzati solo per scattare foto, ma nell’era dell’intelligenza artificiale, le fotocamere dei telefoni cellulari hanno gradualmente sostituito gli occhi umani e hanno la capacità di riconoscere il mondo.

Su questa base è nato Google Lens, inclusa l’identificazione del prodotto, la traduzione della scena reale, l’identificazione delle piante, la ricerca del riconoscimento del testo, ecc., che sono responsabilità di Google Lens.

Con l’aiuto di un nuovo modello di intelligenza artificiale, Google Lens ha anche inaugurato un rapido sviluppo.

La prima è la funzione Cerca nel tuo schermo, che vorrei chiamare una nuova interpretazione di “ciò che vedi è ciò che ottieni”.

Ad esempio, se vedi una torta molto deliziosa su Xiaohongshu, non è necessario saltare fuori dall’app corrente, premi a lungo il pulsante di accensione per riattivare l’Assistente Google, fai clic sulla schermata di ricerca, puoi trovare le informazioni di questa torta, e poi abbinalo alla funzione “Ricerca mista (ricerca multipla)” appena lanciata, puoi cercare luoghi nelle vicinanze dove puoi acquistare questo tipo di torta e soddisfare il tuo appetito in tempo.

Questa funzione di “ricerca ibrida” può perfezionare ulteriormente il contenuto che si desidera ricercare con il testo sulla base del riconoscimento dell’immagine, in modo da ottenere risultati più accurati e diversificati.

È un po’ come la versione illustrata di ChatGPT, ma manca della capacità di dialogo continuo e il risultato finale potrebbe non essere sempre soddisfacente.

Tuttavia, in questo piccolo aggiornamento, possiamo anche vedere le potenzialità di Google nel modello del linguaggio naturale, che potrebbe essere in grado di proporre uno strumento AIGC a tutto tondo prima di ChatGPT, ma non oggi.

La ricerca è ancora un colpo di luna

Prabhakar Raghavan, vicepresidente senior di Google, ha iniziato a introdurre l’aggiornamento sottolineando un punto che potrebbe sorprenderti: la ricerca è ancora un “progetto lunare”.

Il motore di ricerca è ormai molto maturo ed è lo strumento di base utilizzato quotidianamente dalla maggior parte degli utenti di Internet. È così semplice, facile da usare e intuitivo: c’è solo una barra di ricerca e puoi inserire direttamente ciò che desideri vuoi sapere e clicca per cercare.

Ma è anche molto semplice utilizzare il metodo di ricerca, il che rende molto difficile aumentare l’accuratezza della ricerca senza aumentare l’onere per l’utente su questa base. Ci vuole un grande sforzo invisibile per i motori di ricerca per farti passare attraverso strati di informazioni inutili per trovare la risposta quando cerchi.

Google lavora nel campo della ricerca da 25 anni, ma non può ancora garantire che gli utenti possano trovare le informazioni che desiderano ogni volta che effettuano ricerche, pertanto l’introduzione della ricerca assistita dall’intelligenza artificiale è particolarmente critica per migliorare l’esperienza dell’utente ed evitare inutili ripetizioni ricerche.

Prabhakar Raghavan crede che Google stia aiutando le persone a liberarsi dei limiti di un singolo metodo e linguaggio di ricerca, a saltare fuori dalla casella di ricerca per esplorare un mondo più vasto e a rimodellare il significato della ricerca, e questo è solo l’inizio.

Quindi, quanto sono soddisfatti gli utenti del foglio delle risposte basato sull’intelligenza artificiale fornito da Google? Dal punto di vista delle azioni, al momento della stampa, il prezzo delle azioni di Google è sceso del 7,68%.Se Google vuole continuare a garantire la sua posizione di “leader della ricerca”, Bard deve cambiare il motore di ricerca un passo avanti rispetto a ChatGPT.

Nota: questo articolo è stato completato congiuntamente da Huang Zhijian, Wang Zhishao e ChatGPT

#Benvenuto a seguire l’account pubblico WeChat ufficiale di Aifaner: Aifaner (ID WeChat: ifanr), altri contenuti interessanti ti verranno presentati il prima possibile.

Ai Faner | Link originale · Visualizza i commenti · Sina Weibo