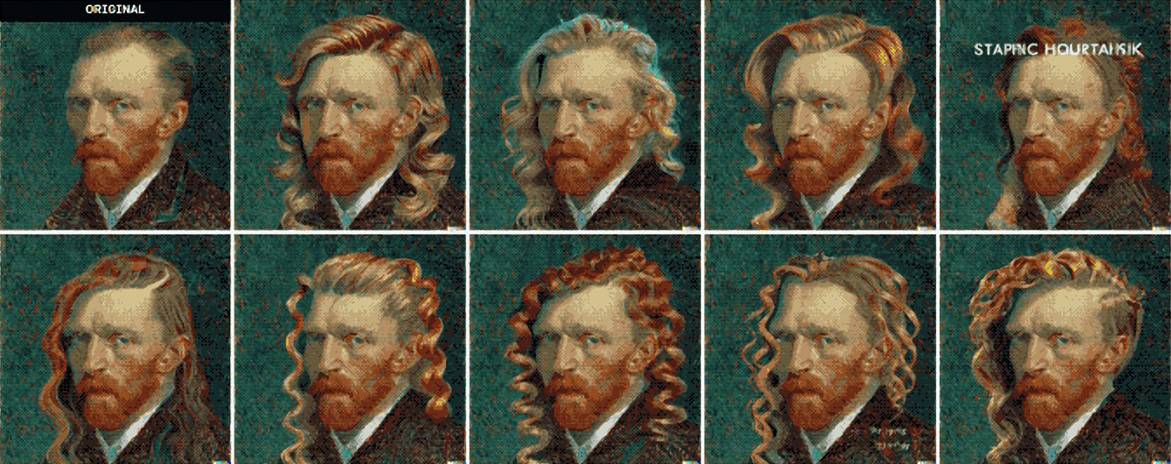

D’ora in poi, tutti avranno un “Van Gogh” nel cellulare

Quanto tempo pensi ci voglia per fare un episodio come questo?

Nell’industria dell’animazione tradizionale, la produzione dell’animazione è spesso il collegamento che richiede più tempo: gli animatori devono produrre gli effetti di animazione di ogni ripresa in base alla sceneggiatura dello storyboard e al design artistico.

Dalla progettazione dei personaggi al disegno delle scene, e poi alla realizzazione delle animazioni, un team di produzione impiega spesso diversi mesi o addirittura un anno.

Ma recentemente, questa legge del settore è stata riscritta dagli strumenti di intelligenza artificiale.

Il cortometraggio animato che stai guardando ora è composto da 120 riprese con effetti visivi e un tempo di esecuzione totale di 7 minuti, e il suo team di produzione, Corridor, ha dedicato solo poche ore all’animazione.

Il segreto dell’efficienza sta nello strumento che usano: la diffusione stabile.

La creatività è ancora una volta scatenata

Come tutti sappiamo, ogni ripresa in movimento nell’animazione è composta da continue immagini in movimento disegnate fotogramma per fotogramma dagli artisti, e dietro ogni episodio di animazione è quasi composto da migliaia di schizzi.

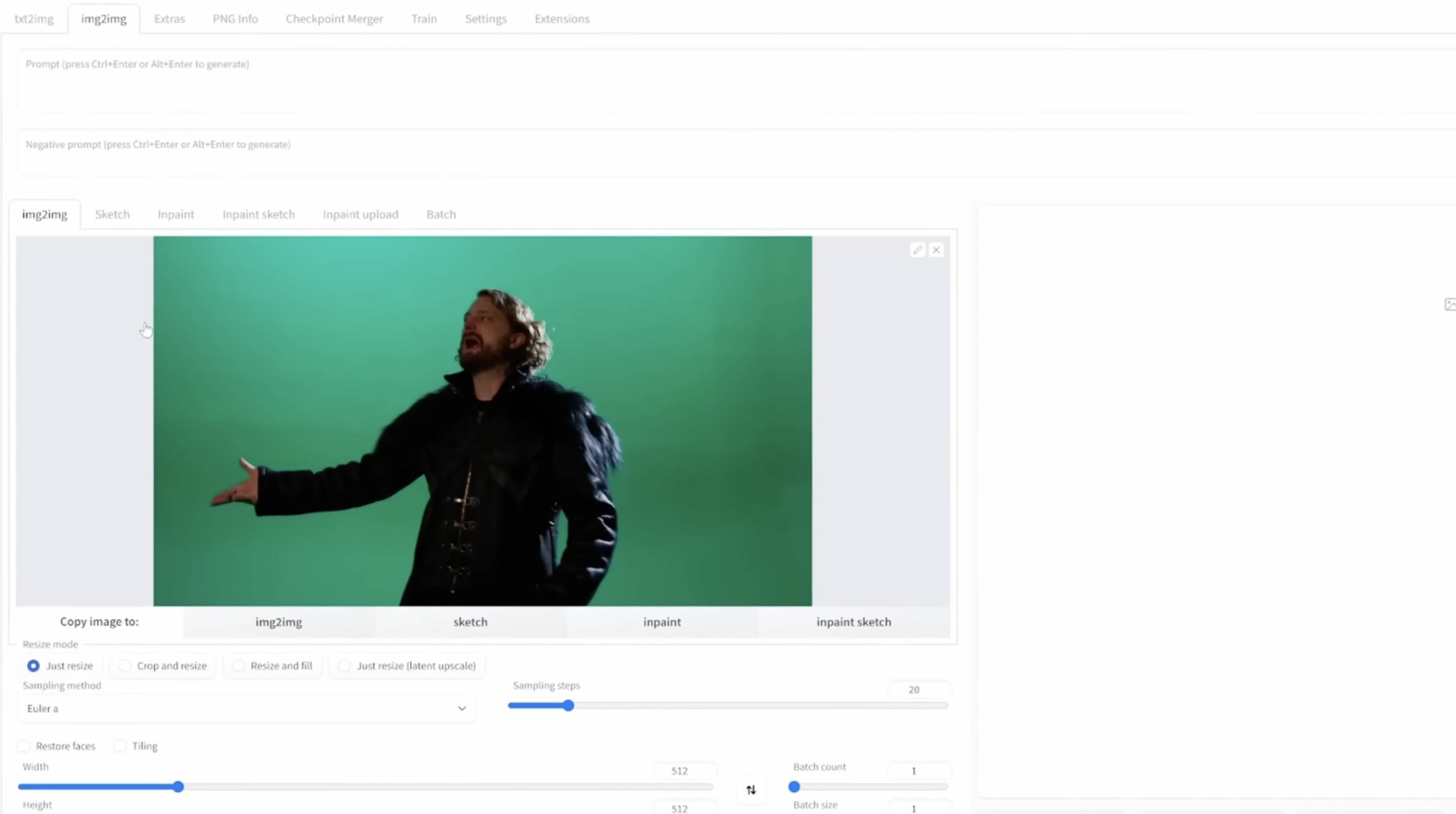

È quasi impossibile per Corridor disegnare a mano l’animazione fotogramma per fotogramma, quindi hanno pensato a un altro modo per realizzare un dipinto: lo scatto della fotocamera è essenzialmente una foto fotogramma per fotogramma, se viene trasformato in uno stile di animazione fotogramma per fotogramma Cucire di nuovo insieme, non è solo animazione?

Per convertire le foto in immagini di animazione in batch, Corridor ha prima pensato allo strumento di disegno AI più popolare: Stable Diffusion.

Rispetto agli strumenti di disegno AI come Dall-E 2 e Midjourney, uno dei vantaggi di Stable Diffusion è che si tratta di un progetto open source: gli utenti possono preparare localmente il database più adatto, lasciare che l’IA impari lo stile di disegno in modo mirato, e quindi generare batch Lo stile dell’immagine.

Secondo l’ambientazione concepita in anticipo, Corridor ha permesso a Stable Diffusion di apprendere un gran numero di immagini di “The Vampire Diaries”, nonché foto da varie angolazioni dei due attori principali, in modo che le immagini animate trasformate possano essere il più accurate possibile e lo stile tende ad essere unificato.

Dopo che Stable Diffusion ha convertito l’intero video in uno stile di animazione, alcune immagini instabili vengono rimosse e lo sfarfallio viene eliminato, e infine lo schermo verde viene sostituito con lo sfondo catturato dalla fotocamera virtuale.In origine, ci volevano una dozzina di pittori per disegnare per diversi settimane L’animazione è completa.

Vedendo questo, vuoi anche usare la tua immaginazione, girare tu stesso un cortometraggio animato o trasformarti in una varietà di eroi fantasy?

Sebbene Stable Diffusion abbia i vantaggi di un’elevata controllabilità, ma per controllarlo, è prima necessario un potente ambiente di elaborazione sul server o sul lato locale per farlo funzionare.

In altre parole, se non hai immaginazione, ma non hai forti capacità di apprendimento ed elaborazione del linguaggio naturale e la potenza di calcolo dell’IA come supporto, non puoi ancora utilizzare Stable Diffusion per creare.

Quindi, c’è un modo in cui le persone comuni possono facilmente disegnare un avatar unico da sole?

Ci sono davvero, e basta che “hai un cellulare”.

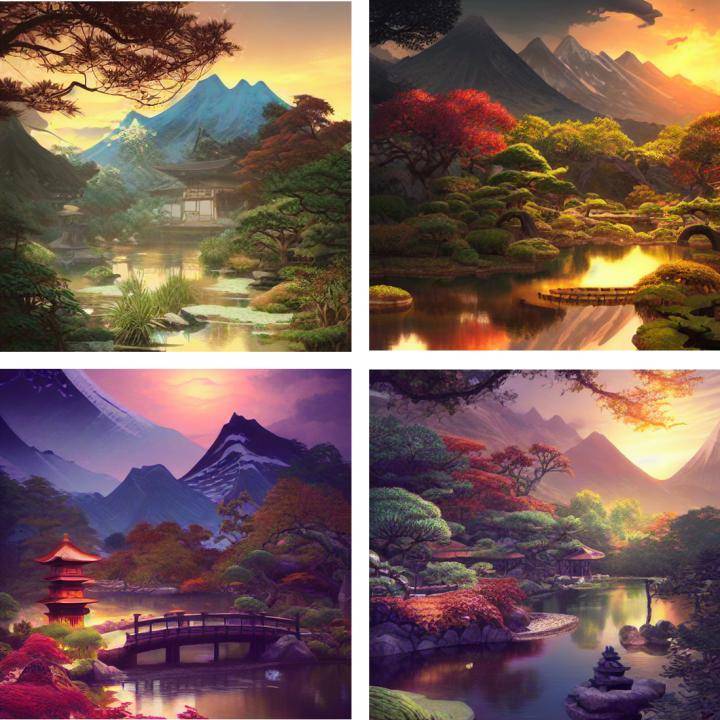

Alla conferenza MWC, Qualcomm ha dimostrato per la prima volta Stable Diffusion in esecuzione localmente su un telefono Android e ha anche mostrato più immagini AI generate sul lato del telefono.L’effetto sembra piuttosto buono e l’intero processo richiede meno di 15 secondi.

I parametri di Stable Diffusion superano 1 miliardo.I computer ordinari sono molto difficili da eseguire.Come fa Qualcomm a “inserire” un modello così enorme nel telefono cellulare e farlo funzionare senza problemi sul SoC del telefono cellulare?

Per “mettere l’elefante nel frigorifero”, gli ingegneri di Qualcomm hanno prima ottimizzato l’elefante.

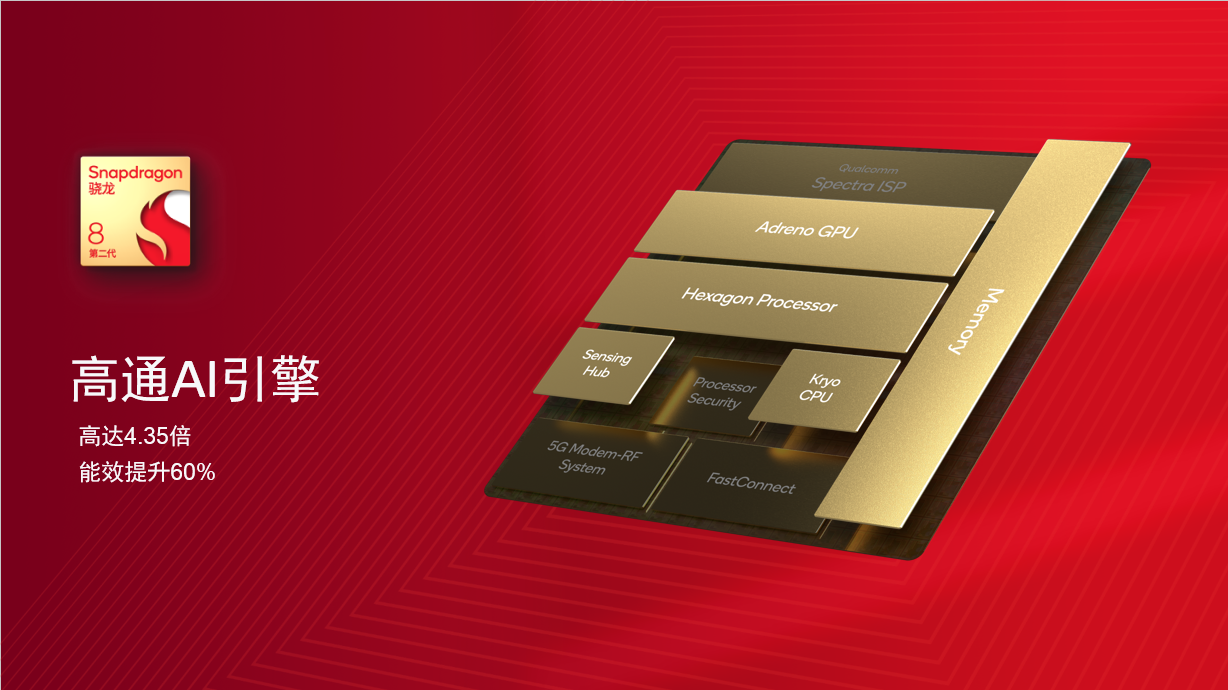

Qui, dobbiamo prima menzionare un importante miglioramento dell’intelligenza artificiale nella piattaforma mobile Snapdragon 8 di seconda generazione, l’elaborazione del linguaggio naturale (NLP).

L’elaborazione del linguaggio naturale è uno dei nuovi campi delle applicazioni AI.Per comprendere e scomporre il linguaggio umano il più rapidamente possibile, Qualcomm ha notevolmente migliorato il processore Hexagon e aumentato l’accelerazione hardware, che può eseguire la rete Transformer in modo più rapido ed efficiente, e ridurre la velocità di elaborazione attraverso il ragionamento micro-slicing.Il consumo energetico fa sì che lo Snapdragon 8 di seconda generazione mostri vantaggi unici nei casi d’uso dell’elaborazione del linguaggio naturale.

Per consentire l’esecuzione di Stable Diffusion sul lato terminale, gli ingegneri di Qualcomm hanno scelto di iniziare con il modello open source della versione FP32 1-5 di Hugging Face e di utilizzare Qualcomm AI Model Enhancement Toolkit (AIMET) per quantificarlo dopo l’addestramento senza sacrificare il modello Nel caso della precisione, il modello FP32 originale viene compresso nel formato INT8 con maggiore efficienza computazionale.

Attraverso la soluzione software AI unificata di Qualcomm Qualcomm AI software stack, Qualcomm può quantificare e semplificare i modelli AI senza perdere la precisione del modello, migliorare notevolmente le prestazioni di ragionamento AI e ridurre il consumo energetico, rendendo i modelli AI di grandi dimensioni più adattabili ai telefoni cellulari e ad altri ambienti di elaborazione a bassa potenza sul lato terminale, facilitando l’espansione lato terminale dei modelli di intelligenza artificiale.

Attraverso l’ottimizzazione software e hardware full-stack, Stable Diffusion può finalmente funzionare sulla piattaforma mobile Snapdragon 8 di seconda generazione integrata con il processore Hexagon, eseguire 20 passaggi di inferenza in 15 secondi e generare un’immagine di 512×512 pixel, in modo che The la velocità è già paragonabile alla latenza del cloud computing.

In altre parole, il modello di intelligenza artificiale generativa su larga scala nel cloud ha compiuto il primo passo nell’espansione delle applicazioni lato terminale.

Anche se non puoi usare Stable Diffusion per girare blockbuster come Corridor, è più che sufficiente usarlo per disegnare la tua testa e scattare ritratti virtuali. Sia che tu voglia un autoritratto nello stile di Monet, Van Gogh o Akira Toriyama, puoi inserire direttamente i comandi sul tuo telefono per generare un’opera AI unica con un clic.

In futuro, i modelli di intelligenza artificiale con una scala di decine di miliardi di parametri potrebbero essere in grado di funzionare sul lato terminale e il livello di intelligenza dell’assistente AI sul tuo telefono cellulare farà un salto di qualità. Le possibilità offerte dall’implementazione sul dispositivo di modelli di intelligenza artificiale generativa vanno oltre ogni immaginazione.

Una naturale esplosione tecnologica

Quando si parla di intelligenza artificiale, la prima cosa a cui molte persone pensano è un grande server cloud: l’intelligenza artificiale sembra essere lontana dalle nostre vite.

Ma in realtà, ogni volta che sblocchi il telefono, attivi il tuo assistente vocale o addirittura premi l’otturatore, è un contatto intimo con l’intelligenza artificiale.

A causa dei numerosi vantaggi dell’elaborazione AI sul lato terminale, inclusi i telefoni cellulari in termini di affidabilità, ritardo e privacy, modelli di cloud AI sempre più grandi hanno iniziato a funzionare sul lato terminale.

Oggi, l’intelligenza artificiale è penetrata in tutti gli aspetti della nostra vita insieme all’implementazione dei terminali.È possibile trovare facilmente l’intelligenza artificiale in prodotti terminali come smartphone, tablet, occhiali XR e persino automobili. Questa è la visione del limite della connessione di rete intelligente che Qualcomm ha costruito e Qualcomm ha lavorato in silenzio per più di dieci anni.

Portare l’intelligenza artificiale dal cloud al terminale può risolvere contemporaneamente i due punti deboli degli utenti: da un lato, i dati elaborati dal terminale possono essere conservati sul dispositivo terminale e la privacy dei dati personali dell’utente è adeguatamente protetta . D’altra parte, i dispositivi terminali possono eseguire calcoli ed elaborazioni in modo tempestivo, fornendo agli utenti risultati di elaborazione affidabili e a bassa latenza.

Questa volta Qualcomm è il primo a implementare Stable Diffusion sui telefoni Android, che non solo offre agli utenti la possibilità di creare AI sempre e ovunque, ma rende anche il futuro editing delle immagini pieno di immaginazione.

I modelli Stable Diffusion codificano una vasta gamma di conoscenze linguistiche e visive e la modifica del modello può avere impatti tangibili nell’editing delle immagini, nell’integrazione delle immagini, nel trasferimento di stile e nella super risoluzione.

Immagina, in futuro, puoi scattare foto o video in stile Disney o giapponese senza Internet e tutti i calcoli delle immagini vengono eseguiti solo sul telefono cellulare, il che è divertente e divertente proteggendo la privacy e la sicurezza.

Nella pianificazione tecnica di Qualcomm, questo è solo l’inizio.

In precedenza, Qualcomm ha rilasciato una soluzione chiamata “Qualcomm AI Software Stack”, in poche parole, è necessario sviluppare un modello solo una volta e può essere esteso a tutti i diversi terminali.

Le scoperte di ricerca e le ottimizzazioni tecniche apportate da Qualcomm su Stable Diffusion saranno integrate in futuro nello stack software AI di Qualcomm.In futuro, dovrà solo essere ampliato su questa base per creare diversi modelli adatti a piattaforme come gli occhiali XR e auto, chiamata anche “roadmap tecnologica unificata” da Qualcomm.

Attraverso un tale percorso di sviluppo del prodotto, Qualcomm può integrare le principali tecnologie AI come l’elaborazione del linguaggio naturale e il riconoscimento facciale sui terminali smartphone in occhiali XR, PC, Internet of Things, automobili e altri prodotti e, infine, creare nuove esperienze intelligenti per gli utenti.

Un modello di sviluppo così altamente flessibile ed efficiente è inseparabile dal motore AI di Qualcomm.

Il motore AI Qualcomm include un’unità di elaborazione grafica, una CPU e il processore Hexagon più critico.

Tra questi, il processore Hexagon è composto da processori scalari, vettoriali e tensoriali.I tre acceleratori utilizzano una memoria condivisa unificata.Qualcomm ha raddoppiato le prestazioni di calcolo dell’acceleratore tensoriale e raddoppiato la capacità della memoria condivisa, rendendo il nuovo La prima generazione Il motore AI di Qualcomm ha migliorato l’efficienza energetica del 70% rispetto alla generazione precedente.

Il motore AI di Qualcomm può essere espanso in modo flessibile nell’hardware e un processore Hexagon è solitamente configurato su una piattaforma mobile; per piattaforme di elaborazione automotive, cloud ed edge, è possibile utilizzare più istanze del processore Hexagon per aumentare la potenza di calcolo.

Combinando i vantaggi dell’architettura e le prestazioni di potenza di calcolo dei principali rivali, si può dire che Qualcomm utilizzi il motore AI di Qualcomm per formare il nucleo di smartphone, Internet of Things, occhiali XR, automobili e altre attività.

Secondo la visione di Qualcomm, l’intelligenza artificiale continuerà a svilupparsi in una direzione completamente distribuita, ovvero il ragionamento AI verrà trasferito dal cloud al lato terminale in gran numero.

Ad esempio, i telefoni cellulari impareranno l’accento dell’utente per migliorare la precisione della voce, le auto impareranno le diverse condizioni stradali e miglioreranno il tasso di riconoscimento degli ostacoli, ecc.

Nel dicembre dello scorso anno, Qualcomm si è unita alla nuova attrice dell’Oscar Michelle Yeoh per descrivere una tale visione futura dell’interconnessione intelligente di tutte le cose:

Gli smartphone stanno diventando più intelligenti grazie al motore AI di Qualcomm. Ha acquisito competenze di imaging professionale, consentendoti di girare scene a livello di film 8K a portata di mano; ha anche capacità di elaborazione del linguaggio naturale e può fornirti attivamente servizi personalizzati come la traduzione in tempo reale come un assistente.

Il motore AI di Qualcomm consentirà alle auto di evolversi in guidatori affidabili. In futuro, le auto possono percepire il tuo arrivo e apportare modifiche adattive in base alle tue abitudini; la potente potenza di calcolo offre ricche funzioni come l’assistenza alla guida, la consapevolezza della sicurezza situazionale e l’intrattenimento in streaming e può anche prevedere la strada da percorrere per migliorare l’esperienza di guida, consentendo di raggiungere la tua destinazione comodamente e in sicurezza.

I dispositivi indossabili come XR ti offriranno un’esperienza più coinvolgente e un’interazione più intuitiva, permettendoti di vagare liberamente nel mondo virtuale e reale.

Tutto sommato, attualmente ci troviamo nel bel mezzo di una miriade di possibilità e le innovazioni dell’IA intorno a noi stanno rimodellando il mondo e cambiando silenziosamente il modo in cui lavoriamo, viviamo e comunichiamo.

Attualmente, gli smartphone sono la migliore piattaforma applicativa per la tecnologia AI, ma la divulgazione della tecnologia AI sugli smartphone è solo il primo passo. In futuro, la tecnologia AI diventerà onnipresente e la produttività e la creatività delle persone saranno ulteriormente rilasciate. Qualcomm ha da tempo stato preparato per questo.

#Benvenuti a prestare attenzione all’account pubblico WeChat ufficiale di Aifaner: Aifaner (ID WeChat: ifanr), altri contenuti interessanti ti verranno presentati il prima possibile.

Ai Faner | Link originale · Visualizza i commenti · Sina Weibo