Crogiolandosi con le foto e chiacchierando, come mai alcune persone pensano che commetterò un crimine?

Opere cinematografiche e televisive come “Minority Report” e “Suspect Tracking” potrebbero essere apparse solo negli ultimi anni. Se si tratta di un lavoro cinematografico e televisivo negli ultimi anni, il pubblico sarà molto “agitato”.

Prevenzione del crimine, modelli predittivi, utilizzo del sistema per speculare su ciò che non è accaduto… Ciò significa che verranno raccolte molte informazioni e significa anche che verrai giudicato da un sistema sconosciuto se c’è una minaccia. La sensazione di affidare il destino all’ignoto, probabilmente non piace a molte persone.

Ma potrebbe non esserci modo di non amarlo, perché prima che tu te ne accorga, sempre più aziende stanno già raccogliendo le tue informazioni pubbliche per giudicare la possibilità del tuo crimine dal contenuto quotidiano del tuo social network.

▲ Immagine tratta da: “Rapporto di minoranza”

I social media si sono trasformati nel più grande informatore, è un self-report?

Voyager, Kaseware, Aura, PredPol, Palantir, che sono alcune aziende che stanno cercando di identificare potenziali minacce attraverso i social network, gran parte di loro collaborano anche con il dipartimento di polizia locale e sono in prima linea nella previsione del crimine.

Ottenere le informazioni richieste dai social media di tutti è il fulcro di questo tipo di società, che utilizzano i contenuti pubblicati dagli utenti sui social network per stimare se l’altra parte è suscettibile di commettere un reato. Gli algoritmi di queste società non sono gli stessi, ma sostanzialmente utilizzano l’intelligenza artificiale per decifrare la linea dell’utente, a giudicare dal contenuto condiviso dall’utente se il soggetto ha commesso un reato, può commettere un reato o aderire a un certo pericoloso ideologia.

▲ Pagina del sito ufficiale di Kaseware

In realtà non si tratta di una novità, dopotutto, nel 2012, alcune persone hanno trasformato i social network nel “pulsante della città”. È difficile vedere uno spazio e un prodotto in grado di accogliere così tanti utenti contemporaneamente e renderli disposti a condividere tutto di sé.

Le caratteristiche dei social network creano le condizioni affinché le persone trovino obiettivi: gli studenti cercano intervistati sui social network, le agenzie di statistica prevedono i risultati delle elezioni sui social network e i detective dell’intelligenza artificiale vogliono trovare criminali sui social network.

Poiché tutti utilizzano i social network, i social network possono spesso riflettere la situazione reale di una persona. Il rappresentante Tyrone Carter dello Stato del Michigan degli Stati Uniti ritiene che la ricerca della polizia sui social network pubblici non abbia violato alcuna legge e non abbia violato i diritti degli utenti, quindi questa previsione è fattibile.

Nel momento in cui fai clic su Invia nella pagina pubblica, il post non è più tuo. Le persone si mettono nei guai a causa di ciò che pubblicano, perché i social media sono il più grande “autoinformatore” che abbia mai visto.

Immagine da: Lifehacker

Ma il segreto sarà svelato solo quando sarà guidato. Voyager Labs, che ha collaborato con il dipartimento di polizia di Los Angeles, ha svolto il ruolo di leader in questo processo. Solo l’organizzazione no-profit Brennan Center ha scoperto attraverso le informazioni pubbliche fornite dal dipartimento di polizia di Los Angeles che il lavoro di Voyager era anche sospettato di discriminazione razziale e violazioni della privacy.

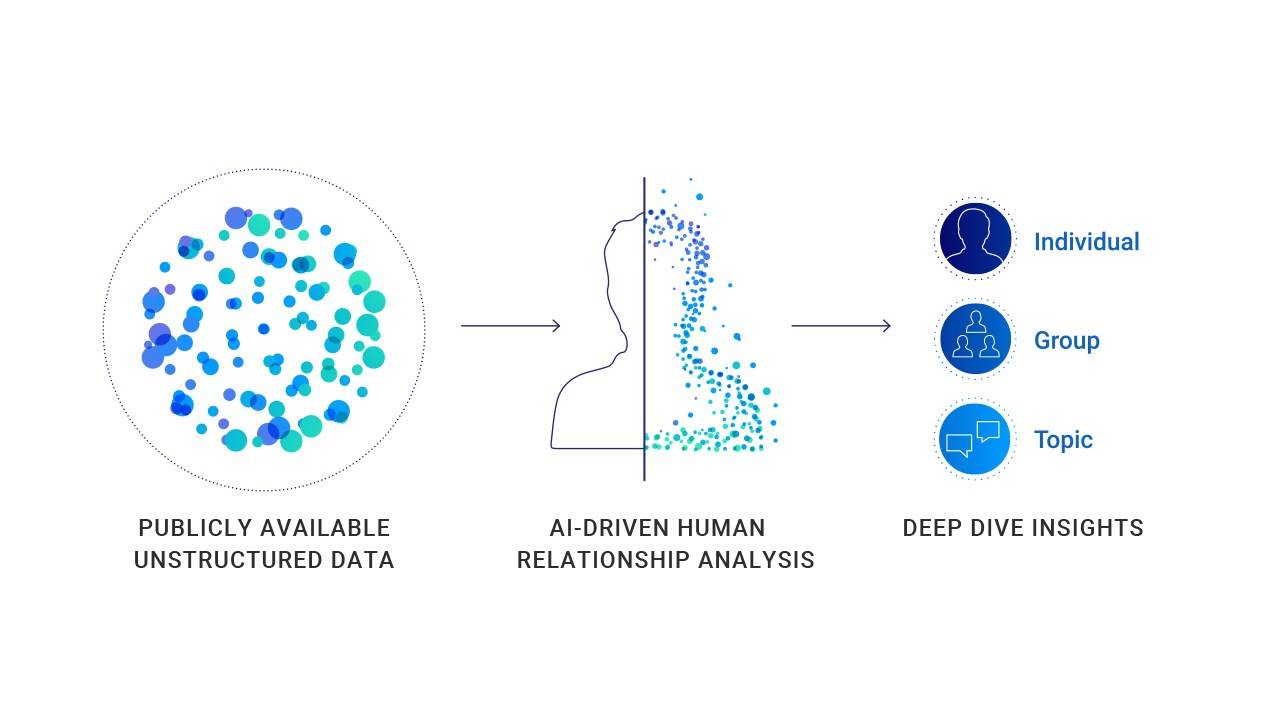

Il modo in cui lavorano aziende come Voyager non è complicato. Raccoglie tutte le informazioni pubbliche sui social media di una persona, inclusi post, contatti e persino emoji di uso comune. In alcuni casi speciali, utilizzerà le informazioni pubbliche e le informazioni non pubbliche per riferimenti incrociati per ulteriori analisi e indicizzazione.

▲ Voyager emetterà giudizi basati su argomenti personali di partecipazione ai social media

Attraverso il servizio di Voyager, la polizia può vedere chiaramente le relazioni sociali di una persona. Come sono le loro connessioni e come interagiscono sulle piattaforme social. Inoltre, Voyager può persino rilevare se esiste una connessione indiretta tra due utenti (entrambi hanno almeno quattro amici identici).

Sembra che stia solo guardando cosa fanno gli utenti sui social network, che viene utilizzato come informazioni supplementari per i sondaggi. Ma in realtà, Voyager non solo raccoglie e visualizza informazioni, ma formula anche giudizi.

▲ Voyager emetterà giudizi e previsioni attraverso la catena di relazioni dei social network

Voyager ha menzionato un caso di aggressione in un white paper presentato al dipartimento di polizia di Los Angeles. Il caso ha dimostrato in modo specifico l’approccio della piattaforma: l’intelligenza artificiale esaminerà automaticamente il contenuto dei post delle persone sui social network senza l’intervento umano. E la classificazione (rispettivamente contrassegna l’utente in tre colori blu, arancione e rosso).

In un caso specifico, Adam Alsahli, il sospettato della sparatoria, è stato giudicato dal sistema come “un forte senso di orgoglio e identificazione con le tradizioni arabe” a causa delle sue foto a tema islamico pubblicate su Facebook e Instagram. Pertanto, Adam Alsahli è stato contrassegnato in arancione dallo strumento di intelligenza artificiale di Voyager prima di lanciare un attacco specifico.

Questo può essere un caso di previsione di potenziali trasgressori, ma anche un caso pieno di “pregiudizi”.

▲ Le informazioni sui social media di Adam Alsahli, il sospettato della sparatoria, sono state contrassegnate in arancione prima che commettesse il crimine

I dati prevedono il crimine? Ma i dati non possono essere completamente creduti

Queste conclusioni sono davvero credibili? In base a che cosa danno giudizi? Come possono tutti dimostrare la loro innocenza sotto i big data?

Ci sono davvero molti dati che confermano la correlazione tra il bias di contenuto dei social network e i fatti criminali, ma questo non è un dato di correlazione al 100%.

La Tanden School of Engineering della New York University e la School of Global Health and Public Health hanno pubblicato risultati di ricerche che mostrano che le città con più discorsi di odio razziale su Twitter hanno tassi di criminalità più elevati; studi in Finlandia mostrano anche che, sulla base di due decenni di dati, per ogni 1°C di aumento della temperatura, l’attività criminale aumenterà dell’1,7%; La ricerca americana ha dimostrato che il tasso di furto di veicoli nelle notti del fine settimana aumenta notevolmente; è stato anche dimostrato che quando la squadra di calcio locale perde accidentalmente, la violenza domestica aumenta del 10%.

▲ L’IA non può prendere decisioni con una precisione del 100%

Ma questi non possono provare nulla, perché la probabilità e il fatto sono diversi.

Anche con l’approvazione di dati rilevanti, non è possibile dimostrare che nelle città con l’incitamento all’odio più razziale, i veicoli devono essere rubati nei fine settimana estivi.Nella stagione calda, quando la squadra di casa locale perde il 100%, si verificheranno più casi di violenza domestica.

Sistemi di previsione del crimine simili vengono invertiti in base ai fatti esistenti sul crimine e ai risultati della ricerca.Un altro problema che questo crea è che è pieno di “stereotipi”.

Il vincitore del premio Turing Yang Likun una volta ha affermato che quando i dati sono distorti, i sistemi di apprendimento automatico diventano distorti. In un singolo caso, quando l’informazione ricevuta dall’apprendimento automatico è che gli utenti di sesso maschile in carcere rappresentano una grande percentuale, un tale sistema può giudicare che gli uomini di colore hanno maggiori probabilità di commettere crimini.

▲ Yang Likun ha detto che il pregiudizio dei sistemi di apprendimento automatico viene dalle persone

Per l’apprendimento automatico, “gli uomini di colore hanno maggiori probabilità di commettere crimini” può essere un dato di analisi dei dati, ma in realtà sarà pregiudizio razziale e trattamento differenziato.

Valutare segretamente gli utenti, dividere quelli che sono più minacciosi e tracciare e prevenire più da vicino quelli che sono minacciati sono la logica di funzionamento dell’intero sistema.

Startup simili utilizzeranno algoritmi e intelligenza artificiale per spiegare il processo che elaborano e analizzare le informazioni per prendere decisioni. Sebbene al momento non ci siano prove per dimostrare che questa previsione sia efficace e ci siano molti dubbi da parte del pubblico, il dipartimento di polizia vuole comunque collaborare con piattaforme simili.

▲Per la polizia, il servizio di previsione della piattaforma è molto prezioso

Per la polizia questo tipo di strumento è molto interessante: la scoperta di piattaforme come Voyager sui social network può fornire un’assistenza efficace nella profilazione degli utenti senza perdere i sottili indizi online. Se si tratta solo di un’indagine ausiliaria, questo sarà uno strumento molto efficace. Tuttavia, quando lo strumento si svilupperà in una fase successiva e inizierà a svolgere un ruolo nella previsione del crimine, diventerà anche un’arma per ferire.

Dopo l’entusiasmo dei finanziamenti degli anni precedenti, molti prodotti AI sono entrati nella fase di applicazione. Ma in alcune aree, hanno ancora il ruolo di ausiliari.

L’assistenza medica è un campo cauto riguardo all’intervento dell’AI. Anche nel campo dell’imaging medico AI più avanzato, la tecnologia AI di oggi non può ancora garantire un’accuratezza del 100% e richiede l’intervento di medici umani. Perché tutti sanno che l’assistenza medica è un settore che richiede un’accuratezza quasi del 100%.Qualsiasi deviazione o errore può causare gravi conseguenze.

▲ In questa fase, potremmo aver bisogno di più della polizia umana

Il campo della polizia è anche un campo che si sforza di essere corretto al 100% e qualsiasi congettura e inferenza senza il supporto di prove causerà anche gravi conseguenze. Una persona che pubblica vari commenti discriminatori e violenti sui social media può essere contrassegnata come potenziale delinquente, con una possibilità del 90% di commettere un crimine violento, ma prima che commetta effettivamente un crimine, è una persona normale.

Nel set di dati complessivo, non possiamo mai ignorare che ognuno è un individuo indipendente.

#Benvenuto a seguire l’account WeChat ufficiale di Aifaner: Aifaner (ID WeChat: ifanr), i contenuti più interessanti ti verranno forniti il prima possibile.

Ai Faner | Link originale · Visualizza commenti · Sina Weibo