Anche la versione a pagamento di ChatGPT è diventata più stupida e OpenAI è stata smascherata per “cambio di modello”, mandando gli utenti in delirio | Hunt Good Weekly Report

Benvenuti all'ultima edizione di Hunt Good Weekly!

In questo numero vedrete:

7 nuove informazioni

4 strumenti utili

1 caso interessante

3 punti di vista chiari

Caccia alle notizie | Titoli in anteprima

Il meccanismo di routing del modello di OpenAI scatena la controversia tra gli utenti

Il meccanismo di routing del modello di OpenAI scatena la controversia tra gli utenti

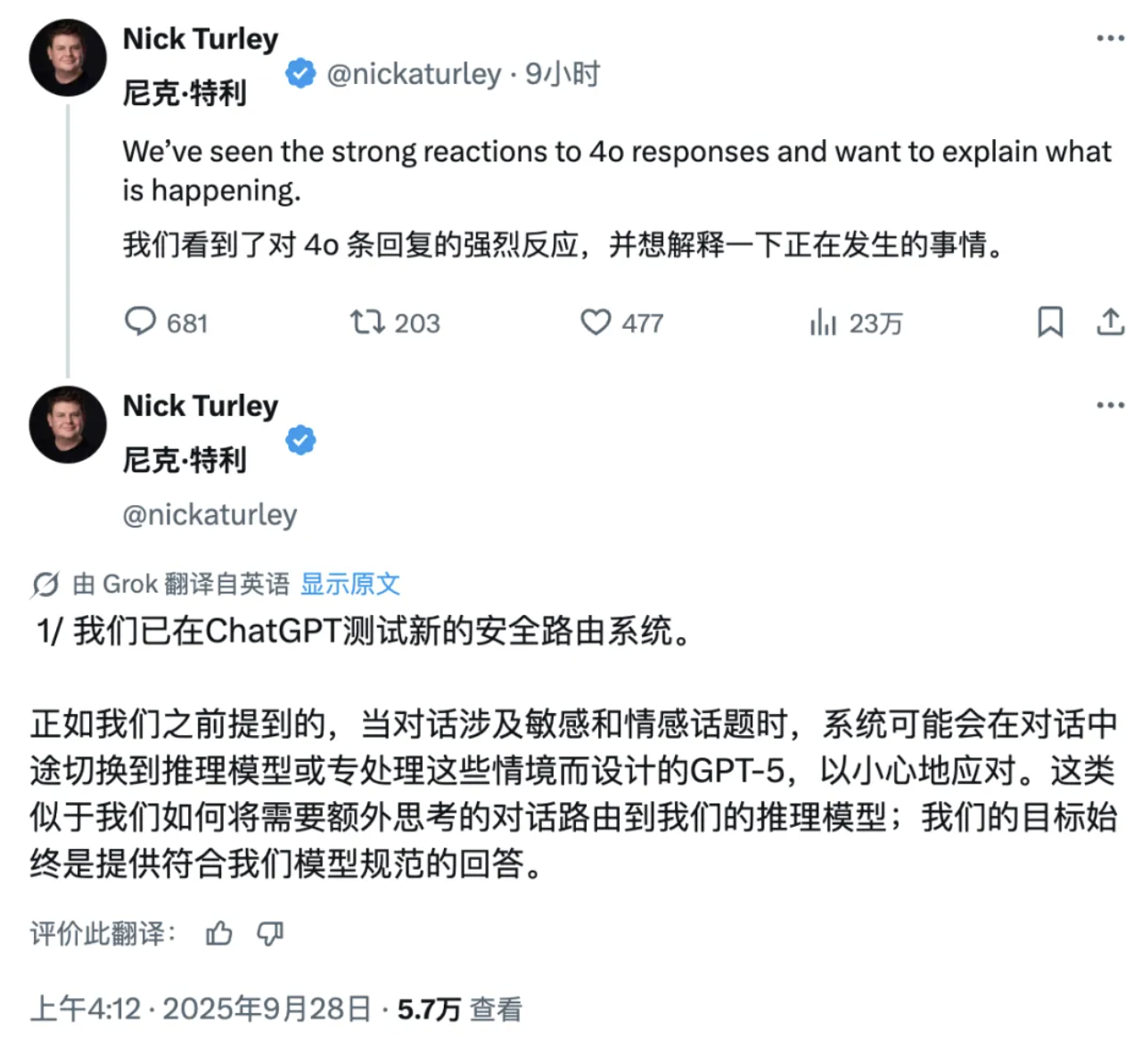

Di recente, il noto blogger X Tibor Blaho ha scoperto che OpenAI sta automaticamente deviando le richieste degli utenti di ChatGPT verso due "modelli segreti" non divulgati, senza il consenso degli utenti.

Secondo Blaho, i due modelli sono "gpt-5-chat-safety" e "gpt-5-at-mini". Il primo è un nuovo modello specificamente progettato per gestire contenuti sensibili, mentre il secondo è un modello di inferenza per il rilevamento di "violazioni" altamente sensibile che innesca una risposta semplicemente inserendo la parola "violazione".

Quando il sistema rileva che la conversazione di un utente riguarda argomenti sensibili, espressioni emotive o informazioni potenzialmente illegali, il sistema indirizzerà automaticamente la richiesta a questi modelli di backend per l'elaborazione, indipendentemente dal fatto che l'utente abbia selezionato la versione GPT-4 o GPT-5. Anche semplici espressioni con lievi connotazioni emotive, come "Sto avendo una brutta giornata" o "Anch'io ti amo", possono attivare il meccanismo di instradamento.

Vale la pena sottolineare che questa pratica non riguarda solo gli utenti gratuiti, ma anche gli utenti Plus che pagano 20 dollari al mese e gli abbonati Pro che pagano 200 dollari al mese. Molti utenti si sono addirittura lamentati del fatto che ChatGPT abbia palesemente ridotto la sua intelligenza.

Nick Turley, vicepresidente di OpenAI e responsabile delle applicazioni ChatGPT, ha ammesso che OpenAI sta testando un nuovo sistema di routing sicuro. Ha spiegato che quando la conversazione riguarda argomenti delicati ed emotivi, il sistema passerà a un modello di ragionamento, o GPT-5, specificamente progettato per gestire rigorosamente tali scenari.

Inoltre, Turley ha sottolineato che questo passaggio dal modello predefinito al modello sensibile è al momento solo temporaneo e ha affermato che ChatGPT continuerà a informare il modello specifico attualmente utilizzato dopo che l'utente ne avrà fatto esplicita richiesta.

https://x.com/btibor91/status/1971959782379495785

https://x.com/btibor91/status/1971959782379495785

MuskxAI fa causa a OpenAI per presunto furto di segreti commerciali

MuskxAI fa causa a OpenAI per presunto furto di segreti commerciali

Il 25 settembre, xAI, l'azienda di intelligenza artificiale di Elon Musk, ha intentato una causa contro OpenAI presso la Corte federale del distretto settentrionale della California, accusando l'azienda di aver rubato segreti commerciali sottraendo dipendenti chiave.

Ad agosto, xAI ha intentato una causa contro l'ex dipendente Li Xuechen, che ha venduto all'improvviso le sue azioni nella società e in seguito è entrato a far parte della rivale OpenAI, anche se non è chiaro se abbia effettivamente iniziato a lavorare lì.

Nell'ultimo atto d'accusa, xAI ha accusato OpenAI di aver "indotto" ex dipendenti, tra cui Li Xuechen, l'ingegnere Jimmy Fratello e un dirigente finanziario senior, a rubare segreti commerciali.

Un'accusa chiave nell'atto di accusa è che OpenAI abbia tentato di ottenere "l'arma segreta" di xAI, ovvero "la capacità di xAI di implementare data center con risorse di elaborazione su larga scala per addestrare ed eseguire l'intelligenza artificiale a una velocità senza precedenti".

Secondo l'atto d'accusa, il "dirigente finanziario senior", di cui non è stato reso noto il nome, ha portato a OpenAI la conoscenza dei processi per la rapida costruzione e scalabilità dei data center. Quando, al momento di andarsene, gli è stato chiesto via e-mail di presunte violazioni dell'accordo di riservatezza, il dirigente ha risposto: "Vaffanculo!". xAI ha allegato uno screenshot dell'e-mail come prova nell'atto d'accusa.

xAI accusa OpenAI di aver condotto una "campagna coordinata, ingiusta e illegale" per reclutare dipendenti chiave di xAI e poi "indurli" a rivelare segreti commerciali a OpenAI, poiché "ha rapidamente raggiunto la posizione dominante tra le aziende di intelligenza artificiale generativa semplicemente perché è stata una 'prima a muoversi'".

In risposta, un portavoce di OpenAI ha dichiarato in un'e-mail: "Questa nuova causa è l'ultimo capitolo delle continue molestie del signor Musk. Abbiamo tolleranza zero per qualsiasi violazione degli accordi di riservatezza e non abbiamo alcun interesse nei segreti commerciali di altri laboratori".

https://sherwood.news/tech/musks-xai-cita-openai-accusa-di-furto-di-segreti-commerciali/

https://sherwood.news/tech/musks-xai-cita-openai-accusa-di-furto-di-segreti-commerciali/

ChatGPT aggiungerà annunci pubblicitari?

Secondo alcune fonti, il nuovo CEO dell'applicazione OpenAI, Fidji Simo, intende formare un nuovo team per introdurre la pubblicità su ChatGPT. Il nuovo team leader sarà pienamente responsabile di tutte le attività redditizie di OpenAI, occupandosi di vari aspetti come la pubblicità e i servizi in abbonamento.

Secondo fonti vicine alla vicenda, Simo ha recentemente incontrato potenziali candidati, tra cui alcuni suoi ex colleghi di Facebook. Le trattative sono ancora in corso e si prevede che il nuovo responsabile della pubblicità riporterà direttamente a Simo.

In aggiunta, Simo è entrato ufficialmente a far parte di OpenAI dopo essersi dimesso dalla carica di CEO di Instacart il mese scorso.

Nella struttura organizzativa di OpenAI, Simo è responsabile della gestione della maggior parte delle unità aziendali, ad eccezione dei team di ricerca, infrastruttura, hardware consumer e sicurezza. Questi dipartimenti principali riportano ancora direttamente al CEO Sam Altman.

https://sources.news/p/openai-ads-leader-sam-altman-memo-stargate?hide_intro_popup=true

https://sources.news/p/openai-ads-leader-sam-altman-memo-stargate?hide_intro_popup=true

Meta punta su una piattaforma robotica "in stile Android"

Meta punta su una piattaforma robotica "in stile Android"

Andrew Bosworth, CTO di Meta, ha rivelato in una recente intervista che, su diretta istruzione del CEO Mark Zuckerberg, all'inizio di quest'anno ha formato un team di ricerca dedicato alla robotica e sta attualmente sviluppando un progetto di robot umanoide denominato in codice "Metabot".

A differenza dei suoi concorrenti, Meta non intende diventare un produttore di hardware. Piuttosto, intende adottare un modello di business simile a quello con cui Google concede in licenza il suo sistema operativo Android ai produttori di telefoni. Meta prevede di sviluppare un progetto software completo e poi concederlo in licenza a qualsiasi azienda che ne soddisfi le specifiche tecniche, consentendo a un maggior numero di produttori di realizzare robot umanoidi basati sulla piattaforma software di Meta.

In termini di tecnologia, Bosworth ha sottolineato che attualmente il principale collo di bottiglia è lo sviluppo del software, non l'hardware in sé.

Durante l'intervista, ha preso un bicchiere d'acqua dal tavolo e ha spiegato: "Questi robot possono stare in piedi, correre e persino fare salti mortali all'indietro perché il terreno è una piattaforma estremamente stabile. Ma se il robot cerca di raccogliere il bicchiere d'acqua, molto probabilmente lo romperà o verserà tutta l'acqua al suo interno". Questo semplice esempio dimostra che la manipolazione abile è ancora una delle maggiori sfide che la robotica deve affrontare.

Per affrontare questa sfida, il Superintelligent AI Lab di Meta sta collaborando a stretto contatto con il team di robotica per costruire un "modello globale" in grado di simulare movimenti complessi delle mani. Bosworth osserva che il circuito di sensori che consente ai robot umanoidi di eseguire movimenti delicati come estrarre con cura le chiavi da una tasca dei jeans con una precisione simile a quella umana non esiste attualmente, quindi il team ha dovuto costruire il set di dati corrispondente da zero.

https://www.theverge.com/column/786759/humanoid-robots-meta

https://www.theverge.com/column/786759/humanoid-robots-meta

Microsoft annuncia che l'assistente Copilot introduce il modello Claude, riducendo la dipendenza da OpenAI

Microsoft annuncia che l'assistente Copilot introduce il modello Claude, riducendo la dipendenza da OpenAI

Il 24 settembre Microsoft ha annunciato l'introduzione del modello Claude di Anthropic nell'assistente Copilot di Microsoft 365.

Grazie a questa nuova collaborazione, gli utenti della funzionalità dell'agente Researcher di Copilot, che raccoglie e analizza informazioni e genera report, possono ora scegliere se far sì che le loro richieste rapide ricevano risposta da un modello Claude o da un modello OpenAI.

Tuttavia, l'utilizzo di questi modelli richiede la previa approvazione di un amministratore ed è soggetto ai termini e alle condizioni di Anthropic.

Vale la pena ricordare che, in qualità di importante investitore e partner chiave per i servizi cloud di OpenAI, Microsoft si è affidata per lungo tempo principalmente ai modelli OpenAI per fornire funzionalità di intelligenza artificiale per la ricerca Bing, il sistema operativo Windows e altri prodotti.

Ma con l'approfondirsi della frattura con OpenAI, oltre a integrare un numero maggiore di modelli linguistici su larga scala dell'azienda, Microsoft ha anche iniziato a testare il proprio modello MAI-1-preview.

Allo stesso tempo, OpenAI ha anche interrotto la sua dipendenza da Microsoft Azure e accelerato l'espansione del suo territorio di cooperazione, raggiungendo accordi enormi che vanno da decine a centinaia di miliardi di dollari con Oracle, Broadcom e Nvidia per supportare la costruzione del suo data center su larga scala.

https://www.cnbc.com/2025/09/24/microsoft-adds-anthropic-model-to-microsoft-365-copilot.html

https://www.cnbc.com/2025/09/24/microsoft-adds-anthropic-model-to-microsoft-365-copilot.html

Trapelata la versione interna di ChatGPT di Apple, in preparazione al nuovo Siri

Trapelata la versione interna di ChatGPT di Apple, in preparazione al nuovo Siri

Secondo un rapporto di Bloomberg di ieri, Apple sta sviluppando un'app mobile simile a ChatGPT per testare e preparare la nuova versione di Siri che verrà lanciata l'anno prossimo.

Secondo alcune segnalazioni, la divisione AI di Apple sta utilizzando l'app per valutare rapidamente le nuove funzionalità di Siri, tra cui test di ricerca di dati personali ed esecuzione di azioni in-app come la modifica delle foto.

Il software, nome in codice interno "Veritas" (in latino "verità"), è attualmente riservato esclusivamente all'uso interno. Sebbene il software non sia previsto per l'uso da parte dei consumatori, la funzione dell'app è essenzialmente quella di estrarre le nuove tecnologie in fase di sviluppo dalla nuova Siri, aiutando così i dipendenti Apple a completare i test in modo efficiente.

Anche senza una pubblicazione pubblica, lo strumento interno segna una nuova fase nei preparativi di Apple per una revisione completa di Siri, che ha già subito numerosi ritardi e il cui lancio è ora previsto per marzo del prossimo anno, si legge nel rapporto.

Veritas si basa sul sistema di base ricostruito da Apple per alimentare la nuova Siri, nome in codice "Linwood". Veritas si basa anche sul Large Language Model (LLM) e incorpora il lavoro del team di modellazione fondamentale di Apple.

Inoltre, secondo un recente rapporto di 9to5Mac, il codice nascosto nelle versioni beta per sviluppatori di iOS 26.1, iPadOS 26.1 e macOS Tahoe 26.1 dimostra che Apple sta gettando le basi per l'introduzione del supporto MCP per App Intents.

Letture correlate: Svelato l'Easter egg nascosto di iOS 26.1, Apple ha creato una nuova "porta C" per ChatGPT

Letture correlate: Svelato l'Easter egg nascosto di iOS 26.1, Apple ha creato una nuova "porta C" per ChatGPT

Meta lancia il servizio di streaming video basato sull'intelligenza artificiale "Vibes", Zuckerberg lo promuove personalmente e viene criticato dai netizen

Meta lancia il servizio di streaming video basato sull'intelligenza artificiale "Vibes", Zuckerberg lo promuove personalmente e viene criticato dai netizen

Meta ha annunciato di recente il lancio di un nuovo flusso video basato sull'intelligenza artificiale chiamato "Vibes".

In un post su Instagram, Zuckerberg ha presentato Vibes come "un flusso di video espressivi generati dall'intelligenza artificiale e realizzati da artisti e creatori". La funzionalità sarà disponibile negli Stati Uniti e in oltre 40 altri paesi.

In termini di design funzionale, Meta ha affermato che gli utenti possono non solo guardare contenuti generati dall'intelligenza artificiale, ma anche creare i propri video o "remixare" video esistenti, aggiungendo anche nuovi effetti visivi e musica.

Per dimostrare la nuova funzionalità, Zuckerberg ha condiviso un video generato dall'intelligenza artificiale intitolato "Papà cerca di calcolare la mancia per un pranzo da 30 dollari". Nel video, una figura paterna che assomiglia a Zuckerberg dice: "Oh mio dio… penso che siano almeno 600 miliardi di dollari".

Tuttavia, il video promozionale di Zuckerberg ha suscitato il ridicolo degli internauti, molti dei quali hanno definito questi video generati dall'intelligenza artificiale "spazzatura dell'intelligenza artificiale" sotto il suo video.

Vale la pena notare che, mentre Meta ha un proprio modello di intelligenza artificiale, Llama, per il progetto Vibes l'azienda ha scelto di utilizzare modelli di generazione video dei laboratori di intelligenza artificiale Midjourney e Black Forest.

https://www.theguardian.com/technology/2025/sep/26/cute-fluffy-characters-and-egyptian-selfies-meta-launches-ai-feed-vibes

https://www.theguardian.com/technology/2025/sep/26/cute-fluffy-characters-and-egyptian-selfies-meta-launches-ai-feed-vibes

Caccia agli strumenti | Strumenti avanzati

L'ex CTO di OpenAI annuncia il suo secondo successo imprenditoriale

L'ex CTO di OpenAI annuncia il suo secondo successo imprenditoriale

Il 27 settembre, Thinking Machines Lab (TML), fondato da diversi ex dirigenti di OpenAI, ha pubblicato ufficialmente il suo secondo articolo di ricerca "Modular Manifolds", che mira a rendere il processo di addestramento dei modelli di grandi dimensioni stabile ed efficiente fin dalla radice.

In parole povere, l'idea centrale di questa ricerca è quella di applicare un "anello stretto" geometrico ai parametri di peso della rete neurale.

Gli approcci tradizionali spesso prevedono l'applicazione di un ottimizzatore a un modello dopo la sua costruzione. Il framework "collettore modulare" fa un ulteriore passo avanti, trattando ogni livello di una rete neurale come uno "spazio geometrico" (ovvero, una varietà) con regole indipendenti. I parametri vengono prima vincolati internamente, e poi questi spazi vengono "cuciti insieme", utilizzando un "limitatore di velocità" globale per coordinare la frequenza di aggiornamento dell'intera rete.

Questo modello integrato e la progettazione dell'ottimizzatore impediscono la perdita di controllo sui parametri interni della rete. Gli esperimenti su piccola scala condotti nell'articolo dimostrano stabilità e accuratezza promettenti.

L'autore di questo risultato è Jeremy Bernstein, ricercatore di apprendimento automatico presso TML, che ha anche condotto una ricerca post-dottorato al MIT.

Questo mese, sei mesi dopo la sua fondazione, TML ha pubblicato il suo primo importante articolo di ricerca, "Sconfiggere il non determinismo nell'inferenza LLM".

Vale la pena ricordare che la valutazione di TML era precedentemente salita a 12 miliardi di dollari (equivalenti a 85 miliardi di RMB) quando aveva “0 prodotti e 0 utenti”.

https://thinkingmachines.ai/blog/modular-manifolds/

https://thinkingmachines.ai/blog/modular-manifolds/

Modello DeepSeek nuovamente aggiornato, la versione definitiva

Modello DeepSeek nuovamente aggiornato, la versione definitiva

Il 22 settembre, DeepSeek ha annunciato che deepseek-chat e deepseek-reasoner sono stati completamente aggiornati a DeepSeek-V3.1-Terminus.

Tra questi, deepseek-chat corrisponde alla modalità non-pensante, mentre deepseek-reasoner corrisponde alla modalità pensante. Secondo quanto riportato, questo aggiornamento mantiene le funzionalità esistenti del modello, ottimizzandolo al contempo in base al feedback degli utenti.

- In termini di coerenza linguistica, la mescolanza di cinese e inglese e occasionali caratteri anomali sono stati attenuati;

- In termini di capacità degli agenti, le prestazioni di Code Agent e Search Agent sono state ulteriormente migliorate.

- Vale la pena notare che gli sviluppatori su diverse piattaforme hanno segnalato che il modello DeepSeek V3.1 presenta anomalie "occasionali estreme", ovvero l'inserimento ripetuto di token come il carattere cinese "极", il carattere inglese "extreme" o il carattere cinese tradizionale "極" (極)) nel codice normale o nell'output di testo. Sebbene la probabilità di questo bug sia di circa una su mille, è sufficiente a causare errori di compilazione o contenuti inutilizzabili. Questo aggiornamento di versione dovrebbe includere anche una correzione mirata per questo problema.

Il nuovo modello è ora open source:

Faccia che abbraccia: https://huggingface.co/deepseek-ai/DeepSeek-V3.1-Terminus

Faccia che abbraccia: https://huggingface.co/deepseek-ai/DeepSeek-V3.1-Terminus  ModelScope: https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.1-Terminus

ModelScope: https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.1-Terminus

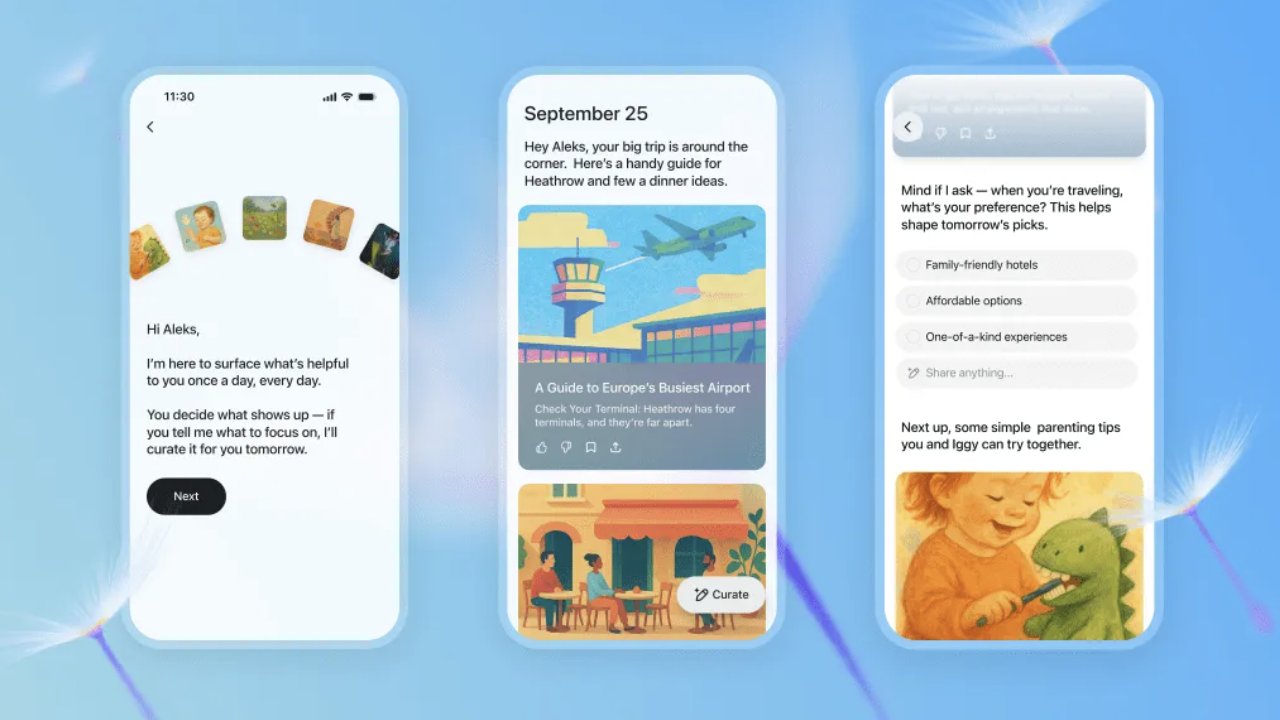

ChatGPT lancia "Pulse", un assistente informativo attivo

ChatGPT lancia "Pulse", un assistente informativo attivo

Il 26 settembre, OpenAI ha annunciato il lancio di una nuova funzionalità "ChatGPT Pulse", ora disponibile in anteprima per gli utenti di dispositivi mobili Pro.

Secondo l'introduzione ufficiale, ChatGPT Pulse genera automaticamente ogni mattina una serie di aggiornamenti di ricerca personalizzati in base alla cronologia chat dell'utente, al feedback e alle applicazioni connesse (come Gmail e Google Calendar). Questi aggiornamenti vengono presentati sotto forma di schede, che gli utenti possono sfogliare rapidamente o espandere per visualizzare i dettagli.

A differenza del tradizionale modello "domanda-risposta" dell'intelligenza artificiale, ChatGPT Pulse punta sulla proattività. Il sistema esegue ricerche asincrone durante la notte, integrando gli interessi degli utenti e il feedback storico per fornire raccomandazioni più mirate il giorno successivo, come "ricette salutari per la cena", "piani di allenamento per il triathlon" o "bozze di ordini del giorno per le riunioni".

Vale la pena notare che gli aggiornamenti di ChatGPT Pulse sono validi solo per il giorno in cui vengono rilasciati. Se un utente non salva o espande un post, le informazioni non verranno conservate a lungo termine. I funzionari hanno sottolineato che l'obiettivo di questa funzionalità è "aiutare gli utenti ad accedere rapidamente alle informazioni chiave, anziché doverle scorrere all'infinito".

Attualmente, "ChatGPT Pulse" è ancora in fase di anteprima. In futuro verrà gradualmente esteso a un maggior numero di utenti e si prevede di supportare un maggiore accesso ad applicazioni di terze parti.

Letture correlate: ChatGPT è stato appena aggiornato, Ultraman: questa è la mia funzionalità preferita

Letture correlate: ChatGPT è stato appena aggiornato, Ultraman: questa è la mia funzionalità preferita

Google DeepMind rilascia un nuovo modello di intelligenza artificiale che consente ai robot di effettuare ricerche sul Web per completare attività complesse

Google DeepMind rilascia un nuovo modello di intelligenza artificiale che consente ai robot di effettuare ricerche sul Web per completare attività complesse

Il 26 settembre, Google DeepMind ha annunciato il lancio di un modello di intelligenza artificiale aggiornato in grado di aiutare i robot a completare compiti più complessi.

È stato riferito che grazie al nuovo Gemini Robotics 1.5 e al modello di ragionamento incarnato Gemini Robotics-ER 1.5, i nuovi modelli di intelligenza artificiale di Deepmind possono lavorare insieme per consentire ai robot di "pensare a più passaggi in anticipo" prima di agire nel mondo fisico.

Il rapporto afferma che i robot saranno in grado di completare operazioni più complesse in più fasi, come ad esempio separare il bucato in base ai colori chiari e scuri, preparare le valigie in base alle condizioni meteorologiche attuali di Londra e aiutare le persone a separare i rifiuti, il compost e i materiali riciclabili in base ai requisiti specifici dell'area.

Carolina Parada, responsabile del dipartimento di robotica di DeepMind, ha dichiarato: "I modelli precedenti sono in grado di eseguire molto bene compiti con singole istruzioni e sono molto generali. Con questo aggiornamento, andiamo oltre l'esecuzione di singole istruzioni, per comprendere e risolvere realmente compiti fisici".

Per raggiungere questo obiettivo, i robot possono utilizzare il modello Gemini Robotics-ER 1.5 per comprendere l'ambiente circostante e sfruttare strumenti digitali come la Ricerca Google per ottenere maggiori informazioni. Questi risultati vengono poi tradotti in istruzioni in linguaggio naturale e trasmessi a Gemini Robotics 1.5, consentendo al robot di eseguire le attività passo dopo passo utilizzando le capacità di visione e comprensione del linguaggio del modello.

DeepMind ha inoltre annunciato che Gemini Robotics 1.5 può aiutare i robot ad "imparare" gli uni dagli altri, anche se hanno configurazioni diverse. Attualmente, DeepMind sta distribuendo Gemini Robotics-ER 1.5 agli sviluppatori tramite l'API Gemini in Google AI Studio, e Gemini Robotics 1.5 è attualmente disponibile solo per alcuni partner.

https://www.theverge.com/news/785193/google-deepmind-gemini-ai-robotics-web-search

https://www.theverge.com/news/785193/google-deepmind-gemini-ai-robotics-web-search

Caccia al divertimento | Gioca per primo

Google lancia l'app Androidify per creare "persone Android" personalizzate

Google lancia l'app Androidify per creare "persone Android" personalizzate

Google ha recentemente lanciato ufficialmente una nuova applicazione Androidify, che consente agli utenti di caricare selfie o inserire parole chiave per generare la propria immagine di un robot Android con l'aiuto della tecnologia AI.

L'app è ora disponibile per il download sul web e su Google Play Store.

Secondo quanto riportato, Androidify integra Gemini e Firebase AI Logic SDK, supportando funzioni quali la verifica delle immagini, la generazione automatica di descrizioni e la generazione di robot personalizzati.

L'applicazione utilizzerà innanzitutto Gemini 2.5 Flash per rilevare le foto caricate dagli utenti, per garantire che le immagini siano nitide e conformi agli standard di sicurezza. Successivamente, genererà una descrizione dettagliata e chiamerà il modello Imagen 3 per generare l'immagine finale del robot.

Vale la pena ricordare che l'ultima versione aggiunge anche la "generazione dell'atmosfera di sfondo" e la "modalità adesivo".

Il primo può aggiungere uno sfondo alla scena del robot tramite il modello Gemini, mentre il secondo utilizza la tecnologia di segmentazione ML Kit per rimuovere lo sfondo e generare adesivi PNG che possono essere utilizzati nelle applicazioni di chat.

Google ha affermato che l'obiettivo di Androidify è consentire agli utenti di sperimentare la creatività e la personalizzazione offerte dalla combinazione di intelligenza artificiale e tecnologia Android, divertendosi.

https://androidify.com/

https://androidify.com/

Caccia all'intuizione

Capo scienziato di OpenAI: dopo la codifica dell'atmosfera, forse arriverà la "ricerca sull'atmosfera"

Capo scienziato di OpenAI: dopo la codifica dell'atmosfera, forse arriverà la "ricerca sull'atmosfera"

In una recente intervista rilasciata a a16z, Jakub Pachocki, Chief Scientist di OpenAI, e Mark Chen, Chief Research Officer, hanno svelato in dettaglio alcune importanti riflessioni e piani futuri sul percorso di sviluppo dell'intelligenza artificiale.

Per quanto riguarda la questione della saturazione degli attuali parametri di valutazione, Jakub Pachocki ha ammesso che il sistema di valutazione da lui utilizzato negli ultimi anni è effettivamente molto vicino alla saturazione. Pertanto, OpenAI si concentrerà sulla capacità dei suoi modelli di scoprire nuove cose e di realizzare progressi concreti in aree economicamente rilevanti.

Jakub ha svelato un grande obiettivo di OpenAI: addestrare ricercatori automatizzati a scoprire automaticamente nuove idee.

Ha menzionato una metrica interessante, ovvero l'intervallo di tempo necessario per osservare il modello mentre ragiona e progredisce. Attualmente, il livello di ragionamento del modello può essere mantenuto per circa 1-5 ore. In futuro, OpenAI si concentrerà sull'estensione di questo intervallo di tempo, sia in termini di capacità di pianificazione a lungo termine che di conservazione della memoria.

In termini di programmazione dell'intelligenza artificiale, Mark Chen ha paragonato il progresso dei modelli di programmazione all'esperienza del giocatore di Go Lee Sedol con AlphaGo, affermando che il progresso dalla risoluzione di problemi di matematica di terza media al raggiungimento del livello professionale nelle competizioni di programmazione un anno dopo è "folle".

Osserva che questo progresso ha già cambiato l'approccio predefinito alla programmazione. I giovani ora considerano l'"ambient coding" la norma, mentre l'idea di scrivere tutto da zero sembra strana. Prevede che il passo successivo all'ambient coding potrebbe essere la "ricerca ambientale".

Quando si tratta di reclutamento di talenti, Jakub Pachocki ritiene che la perseveranza sia una caratteristica fondamentale. La ricerca, per sua stessa natura, consiste nell'esplorare l'ignoto e molti tentativi falliranno, quindi bisogna essere preparati a fallire e imparare da essi. Mark Chen ha aggiunto che non ci sono scorciatoie nella ricerca; scegliere le domande giuste richiede esperienza.

Italiano: https://www.youtube.com/watch?v=KSgPNVmZ8jQ

Italiano: https://www.youtube.com/watch?v=KSgPNVmZ8jQ

Vincitore del premio Turing: i grandi modelli linguistici sono un vicolo cieco

Vincitore del premio Turing: i grandi modelli linguistici sono un vicolo cieco

Richard Sutton, vincitore del premio Turing 2024 e noto come il "padre dell'apprendimento per rinforzo", ha affermato in una recente intervista che i grandi modelli linguistici non possono raggiungere una vera intelligenza e saranno sostituiti da nuove architetture.

Il punto centrale di Sutton è che i grandi modelli linguistici in sostanza imitano semplicemente il comportamento umano, anziché comprendere veramente il mondo.

Secondo Sutton, la vera intelligenza dovrebbe derivare dall'interazione diretta con l'ambiente e dall'apprendimento dall'esperienza, proprio come gli animali apprendono in natura. Sottolineava che gli animali non ricevono mai un "apprendimento supervisionato"; imparano provando azioni e osservandone i risultati, un meccanismo di apprendimento comune in natura.

Quando il conduttore Patel ha affermato che i grandi modelli linguistici sembravano aver costruito un modello del mondo, Sutton ha replicato: "Imitare le persone che parlano non è la stessa cosa che costruire un modello del mondo. Un modello del mondo reale dovrebbe consentire di prevedere cosa accadrà, non cosa diranno le persone".

Sutton ritiene che il problema più grande che si presentano ai grandi modelli linguistici sia la mancanza di un obiettivo chiaro. Ha citato la definizione di John McCarthy: "L'intelligenza è la capacità computazionale di raggiungere obiettivi". Senza un obiettivo, è impossibile definire qual è il comportamento corretto e non si può raggiungere un vero apprendimento.

Ha inoltre spiegato: "Nell'apprendimento per rinforzo, esiste un comportamento corretto, perché il comportamento corretto è un comportamento che può ricevere ricompense. Abbiamo una definizione chiara di cosa sia un comportamento corretto, quindi possiamo testare e imparare". Tuttavia, i modelli linguistici di grandi dimensioni non dispongono di tali criteri di valutazione e non possono ottenere feedback e migliorare nelle interazioni reali.

Durante l'intervista, Sutton ha anche evidenziato i difetti fondamentali nelle capacità di generalizzazione degli attuali metodi di deep learning. Ritiene che, sebbene i modelli linguistici di grandi dimensioni funzionino bene in determinati compiti, questo successo sia spesso dovuto a una singola soluzione piuttosto che a vere e proprie capacità di generalizzazione.

"La discesa del gradiente consente al sistema di trovare soluzioni ai problemi che ha visto, ma se ci sono più soluzioni, alcune delle quali si generalizzano bene e altre male, l'algoritmo stesso non spingerà il sistema a scegliere la soluzione con una buona capacità di generalizzazione." Sutton ha affermato che questo spiega anche perché i sistemi di deep learning sono inclini a problemi come l'oblio catastrofico.

https://www.dwarkesh.com/p/richard-sutton

https://www.dwarkesh.com/p/richard-sutton

Il padre dell'informatica quantistica: decifrare la teoria della gravità quantistica potrebbe diventare un nuovo standard per giudicare l'AGI

Il padre dell'informatica quantistica: decifrare la teoria della gravità quantistica potrebbe diventare un nuovo standard per giudicare l'AGI

Il 25 settembre, durante un evento di dialogo tenutosi presso la sede centrale di Axel Springer a Berlino, in Germania, il CEO di OpenAI Sam Altman e David Deutsch, famoso fisico britannico e "padre dell'informatica quantistica", hanno discusso approfonditamente sui criteri di valutazione dell'AGI e hanno raggiunto un consenso.

Secondo Deutsch, la capacità dei grandi modelli linguistici di condurre conversazioni continue si basa principalmente sull'enorme quantità di formazione conoscitiva che ricevono, mentre la vera intelligenza dovrebbe riflettersi nella capacità di creare conoscenza, ovvero la capacità di scoprire problemi, inventare soluzioni, testarle e migliorarle continuamente.

Per illustrare questo punto, Deutsch cita come esempio la teoria della relatività di Einstein: "Alcuni si sono chiesti se Einstein abbia effettivamente creato la teoria della relatività o se abbia semplicemente combinato meccanicamente idee esistenti. Siamo certi che lo abbia fatto, perché comprendiamo il suo processo di ricerca, i problemi che ha cercato di affrontare e le sue motivazioni".

Tuttavia, ha anche ammesso francamente di aver precedentemente creduto che i computer non potessero avere conversazioni aperte senza l'AGI, ma le prestazioni di ChatGPT hanno ribaltato la sua convinzione. Ha affermato: "Sebbene ChatGPT non sia un'AGI, ha la capacità di avere una conversazione".

In risposta al punto di Deutsch, Altman ha posto una domanda ipotetica: se GPT-8 potesse risolvere il problema della gravità quantistica e descrivere in dettaglio la storia della sua ricerca, inclusa la scelta del problema e la motivazione della ricerca, "sarebbe sufficiente a convincerti?"

Deutsch rispose con decisione: "Penso di sì". Ultraman sorrise e disse: "Sono d'accordo con questo come standard di prova".

https://www.businessinsider.com/sam-altman-predicts-ai-agi-surpass-human-intelligence-2030-2025-9

https://www.businessinsider.com/sam-altman-predicts-ai-agi-surpass-human-intelligence-2030-2025-9

Tempo di uova di Pasqua

Autore: @azed_ai

Parola chiave: Un rendering 3D low-poly di un [soggetto], costruito da sfaccettature triangolari pulite con superfici piatte [colore1] e [colore2]. L'ambiente è un deserto digitale stilizzato con geometria minima e occlusione ambientale.

Collegamento: https://x.com/azed_ai/status/1971892865581350967

#Benvenuti a seguire l'account pubblico ufficiale WeChat di iFaner: iFaner (ID WeChat: ifanr), dove vi verranno presentati contenuti ancora più interessanti il prima possibile.

MuskxAI fa causa a OpenAI per presunto furto di segreti commerciali

MuskxAI fa causa a OpenAI per presunto furto di segreti commerciali Meta punta su una piattaforma robotica "in stile Android"

Meta punta su una piattaforma robotica "in stile Android" Microsoft annuncia che l'assistente Copilot introduce il modello Claude, riducendo la dipendenza da OpenAI

Microsoft annuncia che l'assistente Copilot introduce il modello Claude, riducendo la dipendenza da OpenAI Trapelata la versione interna di ChatGPT di Apple, in preparazione al nuovo Siri

Trapelata la versione interna di ChatGPT di Apple, in preparazione al nuovo Siri Meta lancia il servizio di streaming video basato sull'intelligenza artificiale "Vibes", Zuckerberg lo promuove personalmente e viene criticato dai netizen

Meta lancia il servizio di streaming video basato sull'intelligenza artificiale "Vibes", Zuckerberg lo promuove personalmente e viene criticato dai netizen L'ex CTO di OpenAI annuncia il suo secondo successo imprenditoriale

L'ex CTO di OpenAI annuncia il suo secondo successo imprenditoriale Modello DeepSeek nuovamente aggiornato, la versione definitiva

Modello DeepSeek nuovamente aggiornato, la versione definitiva ChatGPT lancia "Pulse", un assistente informativo attivo

ChatGPT lancia "Pulse", un assistente informativo attivo Google DeepMind rilascia un nuovo modello di intelligenza artificiale che consente ai robot di effettuare ricerche sul Web per completare attività complesse

Google DeepMind rilascia un nuovo modello di intelligenza artificiale che consente ai robot di effettuare ricerche sul Web per completare attività complesse Google lancia l'app Androidify per creare "persone Android" personalizzate

Google lancia l'app Androidify per creare "persone Android" personalizzate Capo scienziato di OpenAI: dopo la codifica dell'atmosfera, forse arriverà la "ricerca sull'atmosfera"

Capo scienziato di OpenAI: dopo la codifica dell'atmosfera, forse arriverà la "ricerca sull'atmosfera" Vincitore del premio Turing: i grandi modelli linguistici sono un vicolo cieco

Vincitore del premio Turing: i grandi modelli linguistici sono un vicolo cieco Il padre dell'informatica quantistica: decifrare la teoria della gravità quantistica potrebbe diventare un nuovo standard per giudicare l'AGI

Il padre dell'informatica quantistica: decifrare la teoria della gravità quantistica potrebbe diventare un nuovo standard per giudicare l'AGI